Dans le prolongement de l'article précédent, je me suis livré à une petite simulation qui explore la période 1976-2100.

hypothèses de base

forçage anthropique

On considère uniquement le forçage du CO2 et on fait donc l'hypothèse que les forçages des aérosols et des autres GES que le CO2 s'annulent.

Les émissions de CO2 en 2100 sont prises égales à 1.5 fois les émissions de 2010 (10 GtC environ).

La quantité totale de carbone fossile brûlée de 2010 à 2100 est ainsi de 1125 Gt, quantité largement inférieure aux estimations des ressources (supérieures à 10000 Gt).

Bien que ce ne soit pas le but ici d'examiner l'attractivité économique d'un carbone fossile de plus en plus difficile à extraire, il est intéressant de signaler que l'actualité récente regorge d'informations, plus ou moins valides évidemment, qui concernent des projets d'extraction dans des conditions qui auraient paru impossibles il y a quelques dizaines d'années seulement.

Citons les russes en mer de Kara (Arctique) , l'or noir de la Guyane française (forage à 6000m de profondeur dont 2000m d'océan), et plus généralement celui de la côte ouest de l'Amérique du sud (Brésil notamment), le pipe line de Keystone pour alimenter le nord des USA avec du pétrole des sables bitumineux de l'Alberta, les gaz de schiste dont l'Europe et les USA, entre autres, semblent particulièrement bien pourvus, etc…

Sans parler du charbon…

forçages naturels

solaire

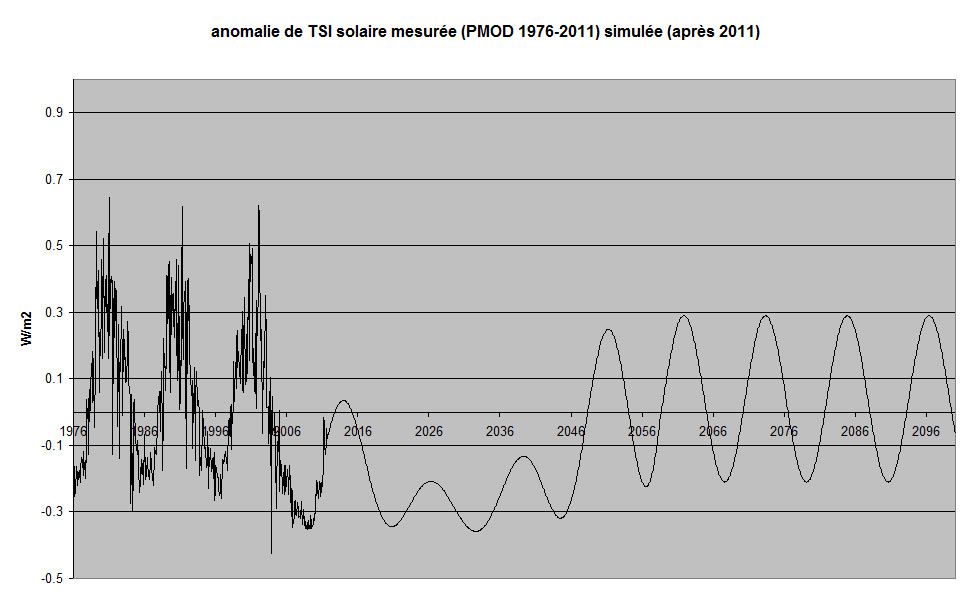

J'ai considéré l'hypothèse, que nous entrions dans une période prolongée de faible activité du Soleil, genre minimum de Spörer ou de Dalton.

Un cycle faible comme celui que nous connaissons actuellement, peut être le premier d'une série de 2 à 3 cycles faibles ainsi que je l'ai représenté sur ce graphique.

Cependant, comme en 1913, il peut précéder une recrudescence d'activité.

C'est dire.

Il est rappelé que le solaire est affecté d'un coefficient multiplicateur de 3.2 pour tenir compte de l'amplitude du signal du cycle de 11 ans.

volcanique

Je n'ai considéré que l'éruption du Pinatubo pour reproduire la température de 1976 à 2010.

variabilité interne

Seule l'ENSO a été prise en compte dans la simulation.

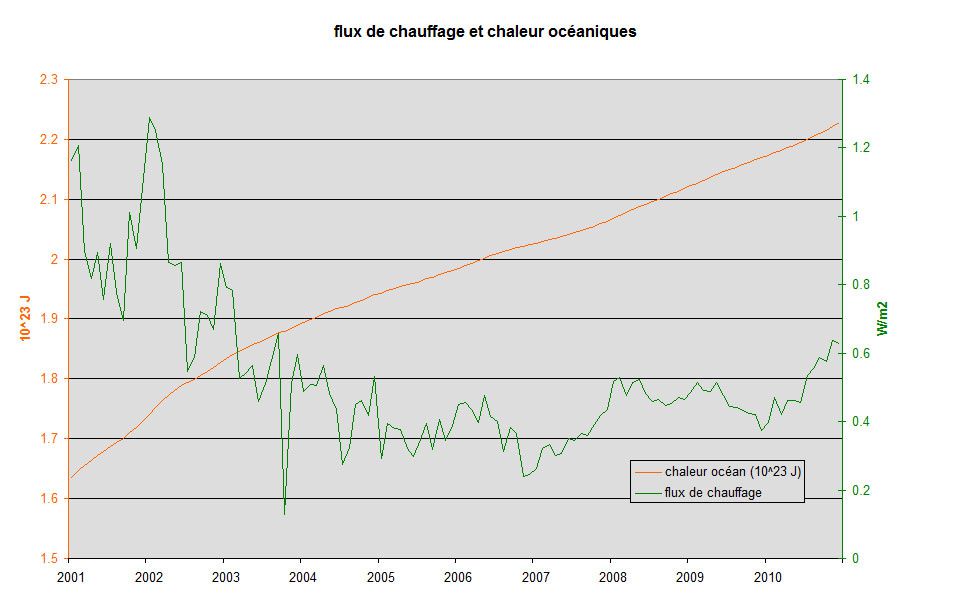

Afin d'avoir une idée du flux de chauffage et de la chaleur océanique, j'ai introduit l'oscillation comme un échange de chaleur entre couches océaniques.

Cet échange, se faisant à bilan nul, est paramétré sur l'anomalie de température Niño34.

J'ai supposé que l'ENSO futur serait le même que celui de ces 60 dernières années.

données simulées

températures

-température de l'océan (surface et couches profondes)

-température globale (se déduit en appliquant un coefficient multiplicateur de 1.2)

chaleur de l'océan

-flux de chauffage

-chaleur cumulée.

La température globale se déduit des SST par l'application d'un coefficient multiplicateur de 1.2.

Plus régionalement, on se reportera aux estimations de modèles plus sophistiqués.

Néanmoins les températures comparées de certaines régions terrestres et de la température globale, font apparaître des coefficients d'amplification assez énormes faisant craindre le pire si le réchauffement continue.

Je ne citerai que l'exemple de Toulouse qui, pendant que la température globale, de 1976 à 2010, s'élevait de 0.17°C/décennie, voyait sa température monter de 0.44°C/décennie.

On espère que, localement, il existe une part importante de variabilité climatique, mais tout de même, un coefficient de près de 2.6, c'est beaucoup.

Tout cela pour essayer de démontrer à ceux qui se gaussent de la faiblesse relative de l'évolution globale (bof qu'est-ce que c'est que 2°C?) qu'ils devraient être un peu plus prudents en considérant les évolutions locales, la France étant sans doute très mal placée de ce point de vue.

résultats

1976-2010

La simulation des SST mensuelles, effectuée avec un coefficient de sensibilité de 0.8°C.m2/W et les forçages de CO2 établis avec les teneurs en CO2 mesurées, est représentée ci-dessous avec la température SST de Hadley.

Le signal simulé est bien sûr moins bruité que le signal mesuré, mais la corrélation entre simulation et mesure est suffisamment convenable (R2=0.809), me semble t'il, pour exploiter le modèle dans un but prédictif avec des hypothèses quant aux oscillations naturelles dont je ne donnerai que l'exemple décrit plus haut.

Concernant la chaleur océanique, on distingue bien une diminution de la pente à partir de 2003 environ.

De 2005 à 2010, le flux de chauffage océanique moyen n'est que de 0.4W/m2 environ.

Les mesures, quant à elles, donnent des résultats qui vont de 0 W/m2 pour 0-700m (Levitus) à 0.55+-0.1 W/m2 pour 0-1500m (Von Schuckmann et Le Traon 2011 avec ARGO seuls).

Je suis incapable de décider qui a raison entre les deux mais le chiffre donné par le modèle est plutôt en accord avec les 0.55 W/m2.

Prédictions suivant les hypothèses retenues

Voici la température de l'océan de 1976 à 2100 en rappelant qu'il faut multiplier par 1.2 pour le global (terres+océans), par 1.6 pour les terres uniquement, et, pour certaines zones, par plus de 2, voire 5 à 10 en Arctique).

L'hypothèse de minimum solaire type Dalton provoque une stagnation relative des températures jusqu'en 2020-2025, mais au-delà, bien sûr, çà monte très franchement avec une hypothèse d'augmentation du CO2 qu'on peut qualifier de moyenne ou de réaliste, comme on veut.

L'augmentation linéaire, de 1976 à 2100, de la température océanique est de 0.12°C/décennie, de la température globale, de 0.144°C/décennie, et des terres, de près de 0.2°C/décennie.

Le CO2, en fin 2100, est à 586 ppm en volume, ce qui correspond à un forçage par rapport au préindustriel, de 4 W/m2.

Rappelons que si ce forçage était maintenu, la température d'équilibre finale serait, avec les hypothèses retenues, de 3.2°C.

Soit plus du double de la température la plus élevée du graphique.

La conclusion rejoint celle de l'article précédent.

Pour expliquer les températures constatées depuis 1976, les forçages anthropique et solaire (moyennant les hypothèses retenues) suffisent, avec l'ENSO, pour reproduire les températures mesurées et la stabilisation des dix dernières années, sans que soit remise en compte, en aucune façon, le réchauffement de fond.

La prédiction des températures des toutes prochaines années, montre que la température ne peut continuer à se stabiliser que dans l'hypothèse d'une activité solaire encore en baisse, typique d'un minimum de Dalton ou de Spörer.

Mais, malgré cette hypothèse sévère, les températures recommencent à monter à partir de 2020/2025, pour atteindre des valeurs globales modérées dont il faut rappeler, à chaque fois, une déclinaison locale très préoccupante.

Enfin, dans ce modèle à forte absorption de chaleur océanique, l'équilibre, à teneur en CO2 constante, est atteint plutôt vers la fin du 22ème siècle.

La teneur en CO2 constante imposant une réduction notable des émissions, évidemment.