Les aérosols, particules solides ou liquides, dont la très petite taille leur permet de flotter dans l’atmosphère, ont des propriétés radiatives très puissantes, notamment par diffusion et

absorption du rayonnement électromagnétique.

On parle de l’effet direct des aérosols pour exprimer le forçage radiatif induit par l’aérosol lui-même.

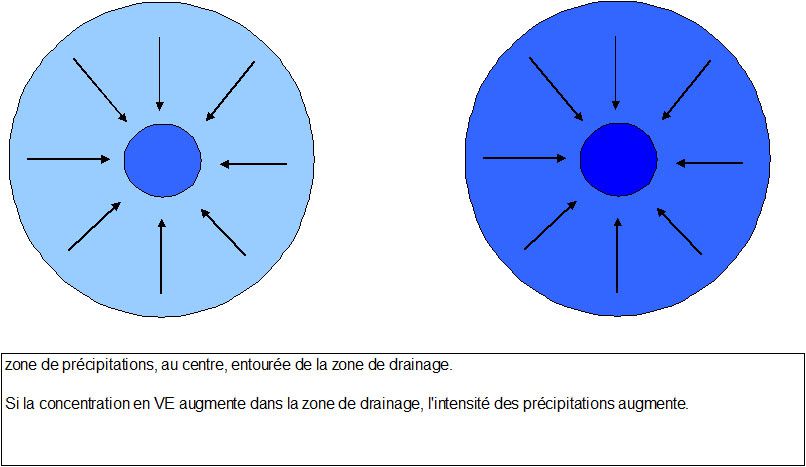

Les aérosols peuvent servir de noyaux de nucléation autour desquels se forment les gouttelettes d’eau ou de glace qui composent les nuages.

Ils ont donc un effet sur la taille et la concentration (CDCN) de ces gouttelettes et, de ce fait, modifient les propriétés radiatives des nuages, notamment en augmentant leur réflectivité.

Ils modifient également la façon dont les précipitations vont se former dans le nuage en les diminuant.

L’ensemble de ces effets sur les nuages constitue l’effet indirect des aérosols.

Dans cet article il sera question du forçage total des aérosols, résultant de la somme des effets direct et indirect.

Etant donné l’immense hétérogénéité des propriétés des aérosols, les conditions infiniment variées d’émission (hauteur, circulation atmosphérique, lieu, …), la plus grande complexité des

interactions avec le rayonnement (qu’elle ne l’est par exemple pour les GES) et enfin la complexité des phénomènes se passant dans les nuages, on conçoit que la détermination du forçage des

aérosols soit plutôt ardue.

Cependant, de nombreuses techniques de mesures et ou détermination existent, aboutissant à une meilleure estimation de -1.2W/m2, avec cependant une marge d’erreur très importante.

Dans ce contexte, signalons cette étude très récente, parue dans JGR dont voici la traduction de l’abstract :

An observationally based energy balance for the Earth since 1950

Murphy, D. M., S. Solomon, R. W. Portmann, K. H. Rosenlof, P. M. Forster, and T. Wong (2009), An observationally based energy balance for the Earth since 1950,

J. Geophys. Res., 114, D17107, doi:10.1029/2009JD012105.

« Nous examinons le bilan énergétique terrestre depuis 1950, identifiant des résultats obtenus sans l’utilisation de modèles climatiques.

les termes importants qui peuvent être obtenus en utilisant seulement les mesures, les modèles de transfert radiatifs, sont le contenu en chaleur de l’océan, les forçages radiatifs des GES

(Gaz à effet de serre), et des volcans.

Nous considérons explicitement l’émission d’énergie d’une Terre qui se réchauffe, en utilisant les corrélations entre température de surface et les données de flux radiatifs mesurés par

satellite et montrons que ce terme est déjà significatif.

Environ 20% du forçage des GES, des volcans et du Soleil, depuis 1950, a été rayonné dans l’espace.

Seulement 10% du forçage positif (soit 1/3 du forçage net) a réchauffé la Terre (presque entièrement les océans).

20% a été équilibré par les aérosols volcaniques.et les 50% restants sont principalement attribuables aux aérosols anthropiques.

Après avoir tenu compte des termes mesurés le forçage résiduel entre 1970 et 2000, du au forçage des aérosols, à l’effet semi direct ( ? ) des GES ainsi qu’à celui de mécanismes inconnus

peut être estimé à 1.1 +-0.4 W/m2.

Ceci est consistant avec les meilleures estimations de l’IPCC mais exclut les valeurs très importantes de forçage indirect des aérosols.

Plus loin, les données impliquent une augmentation des années 50 aux années 80 suivie par une constance ou légère décroissance jusque dans les années 90 consistantes avec les enregistrements

d’émissions de sulfates.

Une augmentation apparente dans la deuxième moitié des années 90 est discutée. »

Voici quelques explications complémentaires issues ou inspirées par la lecture de l’étude en elle-même.

Leur compréhension implique qu’on soit un peu familiarisé avec les bilans TOA et donc qu’on ait lu les articles de ce blog qui en parlent (entre autres sources bien sûr)

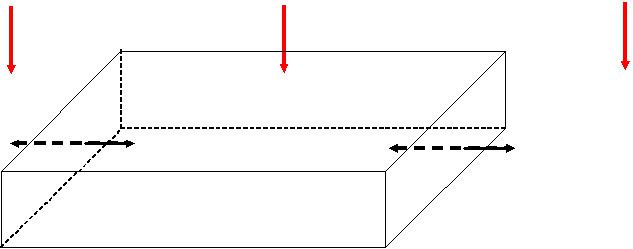

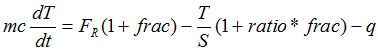

L’étude est donc bâtie autour de l’équation suivante :

N = -λ ΔT + F +ε

où :

N est le flux net TOA

λ ΔT est le flux induit par le changement de température (en supposant la linéarité)

F est le forçage net

ε est le bruit et la variabilité interne.

sur un temps suffisamment long 1/λ représente la sensibilité climatique S.

Cette formule n’est pas sans rappeler celle déjà utilisé ici dans cet article par exemple, mais on fera attention aux noms de

variables différents.

détermination de λ

L’équation ci-dessus peut être utilisée de manière à ce que l’on ait:

flux montant – F = -λ T

on a d’autre part

F = Fc + Fi où c et i désignent « connus » et « inconnus » respectivement.

Fc = F GES + F volcans + F solaire

Fi = F des aérosols, principalement.

Fi, par définition, n’est pas connu mais il est supposé constant au cours des 2 périodes de mesures satellitaires soit 1985-1999 pour ERBE et 2000-2005 pour CERES.

Des mesures de l’effet direct ainsi que les mesures de la concentration en sulfates piégés dans les glaces appuient cette hypothèse.

En conséquence la détermination de λ se fait par mesure de la pente de la régression linéaire de :

flux montant – Fc

on peut appeler le flux montant, N également, puisque les variations du flux descendant (solaire) sont prises en compte.

comme dans l’étude, Fc sera pris égal à F, et donc λ est bien la pente de la droite (issue de la régression) N - F en fonction de T.

notons que T est cette fois la température absolue de la surface.

les différents points de mesure concernent des mesures inter-saisonnières et interannuelles en conséquence les périodes sont trop courtes pour que l’on puisse assimiler 1/λ à S.

Toutefois, sur l’ensemble des 2 périodes, la relative constance de λ peut permettre le rapprochement de son inverse avec la sensibilité long terme.

Le flux montant N est la somme des flux SW (visible) et LW (IR) mesurés par les satellites.

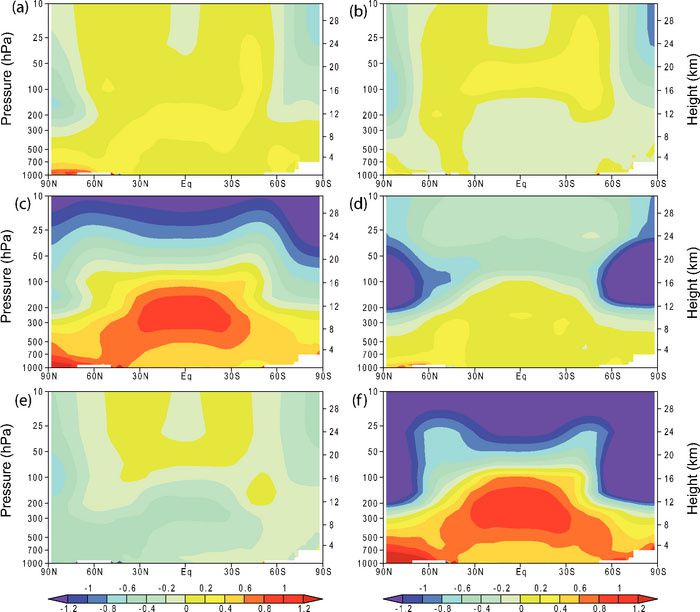

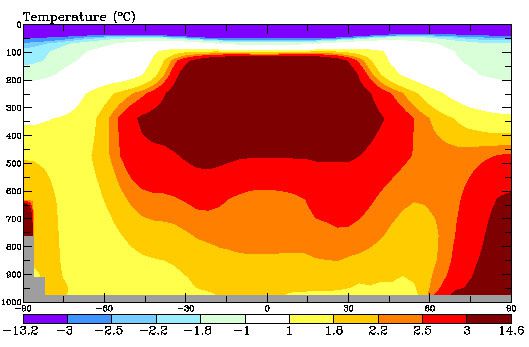

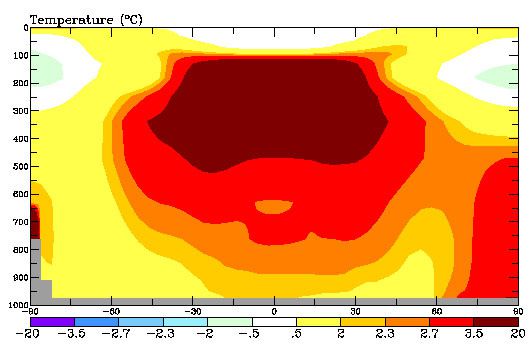

Voici ci-dessous l’allure des régressions linéaires.

Le flux LW augmente avec la température, ce qui est assez normal

Pour le SW, il diminue, une partie de l’explication pouvant résider dans la diminution des zones enneigées avec la température, mais il n’y a pas grand chose à ce sujet dans l’étude.On peut aussi

imaginer une variation des nuages.

La valeur de λ, déterminée par régression linéaire, est de 1.25 +- 0.5 W/m2.°K

notons que l’inverse de cette valeur aboutirait à une sensibilité 2*CO2 de 3.5 +- 1.4°C.

détermination du forçage des aérosols

revenons à l’équation initiale:

N = -λ ΔT + F +ε

qu’on peut modifier de la façon suivante :

N = -λ ΔT + Fc +Fi (ε est intégré dans Fi)

λ est considéré comme une constante intrinsèque au système climatique terrestre, ne variant par conséquent pas, du moins dans l’intervalle 1950-2005.

ΔT est l’anomalie de température (par exemple l’anomalie issue de HadCRUT)

on connaît donc -λ ΔT

on connaît Fc

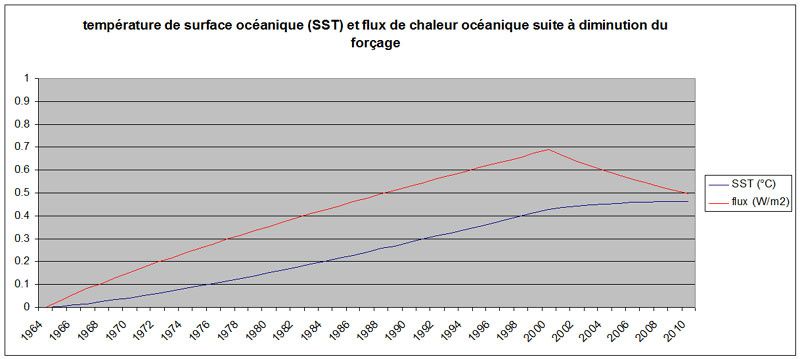

on connaît N = puissance thermique fournie au système par les mesures de chaleur de l’océan (Domingues, GECCO,…)

par conséquent on connaît Fi = N +λ ΔT - Fc

La valeur du Fi moyen de 1970 à 2000 est -1.1 +- 0.4 W/m2 avec les données de chaleur océanique de Domingues.

Cette valeur est consistante avec la meilleure estimation du GIEC, -1.2W/m2, mais elle en restreint fortement la fourchette, excluant ainsi les valeurs très fortes de forçage

indirect.

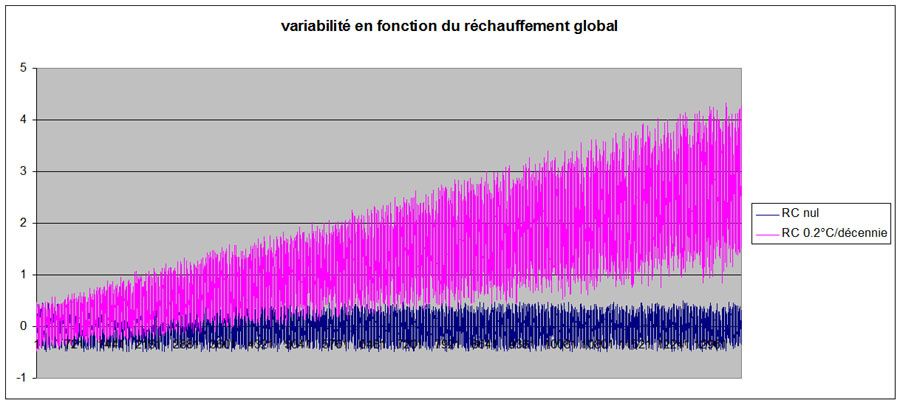

évolution du forçage de 1950 à 2005

les auteurs repèrent une augmentation du forçage des 50s aux 80s, puis une très légère diminution ou une quasi stagnation, avec toutefois un saut vers 1996.

Ce saut, corroboré par aucune autre analyse, laisse penser aux auteurs qu’il s’agit d’un biais du aux mesures de chaleur océanique.

quelques réflexions supplémentaires

L’attribution du forçage inconnu en quasi-totalité aux aérosols peut laisser dubitatif, surtout que cette attribution est utilisée dans la détermination de λ.

Néanmoins on ne connaît pas de forçage négatif naturel suffisamment important pour être pris en compte.

Alors c’est un peu par défaut, ce qui est dommage.

La prise en compte de courbes de chaleur océanique différentes donnent des valeurs de forçage d’aérosols quelque peu différentes, mais pas en dehors de la fourchette.

Cependant, les auteurs ne semblent pas douter de la variation de forçage aérosols au cours de la période sauf pour 1996. Leur raisonnement manque peut-être de rigueur quoique qu’il s’appuie sur

les mesures altimétriques de niveau de la mer.

Si l’on s’attache aux résultats, en dehors de ces quelques critiques, les proportions signalées dans l’abstract peuvent paraître surprenantes.

en effet, l’énergie cumulée apportée au système depuis 1950 par les GES et le forçage solaire a été consommée de la façon suivante :

20% a été équilibrée par les volcans

20% a été rayonnée dans l’espace

10% a chauffé les océans

50% a été équilibrée par les aérosols anthropiques.

C’est le 20% rayonné dans l’espace qui nous donne la variation de température de surface.

Si on traduit en flux, 20% représente un flux moyen de 0.384 W/m2 rayonné vers l’espace, alors que la variation de température moyenne est de 0.3°C pendant cette période.

Ceci aboutit à une sensibilité climatique, en utilisant l’équation plus haut, de 0.78 °C.m2/W.

Ce, seulement, 20% de chaleur rayonnée, nous donne la mesure de ce pourrait être vraiment le RC, si aucun forçage négatif n’existait.

Rappelons que ce forçage négatif par les aérosols (si on tient compte des résultats de l’étude) compense 70% du forçage positif GES + solaire.

La hausse de la température moyenne aurait été 5 fois plus forte, soit de l’ordre de 1.5°C au cours des 50 dernières années, ce qui est, fort heureusement, une hypothèse d’école.

Le flux de réchauffage de la Terre est très faible en proportion, puisqu’il représente seulement 10% du flux positif total.

Cependant il témoigne du fait qu’il y a environ 0.15°C (toujours en moyenne sur les 50 dernières années) dans le « tuyau », ou si on raisonne en gros, et par rapport à la situation

actuelle, 0.3°C par rapport à 0.6°C.

Voilà, c'est un peu compliqué, mais cela permet une évaluation du forçage des aérosols et de la sensibilité en se basant sur les observations (plus les modèles de transfert radiatif qui

permettent de calculer les forçages connus) sans avoir recours aux modèles climatiques.