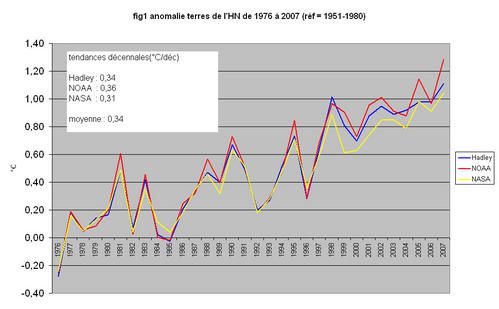

Il s'agit, dans cet article, de faire un panorama de la nature des variations et des mesures de l'activité solaire, ainsi que d'aborder son influence sur

le climat de ces tous derniers siècles.

Pour des raisons indépendantes de la volonté de l'auteur de cet article, certaines images et figures

ont disparu.

Nous vous demandons de bien vouloir nous excuser pour ce désagrément.

le soleil en quelques chiffres (1)

Une très grosse boule d'un rayon de 695990 km, soit 109 fois plus grand que la Terre.

Sa masse est de 1.989 1030 kg soit 330000 fois la masse de notre planète.

Il est 1050 fois plus massif que la planète la plus lourde du système solaire, Jupiter, et représente 99.85% de la masse du système solaire.

Les réactions nucléaires de fusion, qui ont lieu dans le cœur de l'étoile dégagent de l'énergie se dissipant à la surface du soleil, au travers des zones radiative et convective.

La température externe de la zone convective (appelons la, la surface) est de 5770 °K.

On peut remarquer que toute l'énergie du soleil est émise par la surface d'une densité très faible, soit 1.6 10-4 la densité de l'air à la surface de la Terre.

C'est donc un gaz presque évanescent qui rayonne toute la puissance des réactions nucléaires ayant lieu dans un cœur dont la densité est plusieurs fois celle de l'acier.

La puissance dissipée, sous forme radiative, est de 3.846 1026 W.

Cette puissance se conserve en cheminant dans l'espace, mais son flux (en W/m2) diminue avec le carré de la distance à l'astre.

La Terre, qui est à une distance moyenne de 149.6 Mkm2, reçoit ainsi un flux de 1367 W/m2 environ.

Le disque terrestre reçoit donc une puissance de 1.748 1017 W soit 0.45 milliardième de la puissance solaire totale.

La puissance solaire reçue par la Terre, au sommet de l'atmosphère, est près de 12000 fois la puissance utilisée par l' humanité.

C'est ce flux qui est responsable des caractéristiques thermodynamiques de la surface, des océans et de l'atmosphère terrestres.

La TSI (Total Solar Irradiance) et le flux solaire TOA (Top of Atmosphere) varient par:

- augmentation sur le très long terme, 6.7% par milliard d'années, due au "vieillissement" (noyaux de plus en plus lourds) de la matière solaire et à l'évolution des réactions

nucléaires vers des réactions plus énergétiques.

- variations de l'orbite terrestre

- variations à court et moyen terme (années, décennies,…,)

variations à court et moyen terme

elles sont dues essentiellement à l'activité magnétique du soleil.

Tout mouvement de particule chargée engendrant un champ magnétique, le plasma qui compose le soleil crée des champs magnétiques puissants.

La génération et l'organisation du magnétisme solaire sont réalisées par ce que l'on appelle la dynamo solaire.

Cette dernière fait l'objet de nombreuses recherches et études très complexes, visant à modéliser son fonctionnement.

Le bouclage des lignes de champ sur elles-mêmes, l'effet alpha, engendre, au travers de la couche convective, différents

phénomènes, comme les les taches solaires et les facules.

Les taches sont plus sombres que la surface du soleil, elles diminuent donc la TSI, tandis que les facules sont plus brillantes et l'augmentent.

La variation de TSI globale du soleil, est donc la somme algébrique des contributions des taches et des facules.

Cette somme est toujours en faveur des facules.

Ceci entraîne, qu'en période de forte activité, visible par un grand nombre de taches, la TSI augmente.

Les facules accompagnent principalement les taches solaires, mais sont aussi réparties sur l'ensemble de la surface où elles constituent le "réseau magnétique" (2)

Il n'a pas encore été repéré (2), de variations de TSI en dehors de ces phénomènes magnétiques.

Il faut distinguer 2 cycles d'activité, en fait liés.

Le cycle de 11 ans ou cycle de Schwabe, qui concerne l'amplitude du champ magnétique et donc du nombre de taches (et de facules) et le cycle de 22 ans qui concerne le sens du champ magnétique.

Tous les 11 ans le champ magnétique s'inverse et sa direction redevient identique au bout de 22 ans.

Les causes de cette périodicité ne sont pas encore parfaitement comprises, mais tout tient très probablement dans le fonctionnement de la dynamo solaire, voir (1).

Les modèles magnétohydrodynamiques actuels ne permettent pas de retrouver la périodicité du cycle mais, par contre, ébauchent déjà le fait qu'un cycle existe et que son intensité soit variable

voire nulle pendant plusieurs décennies.(fonctionnement chaotique de la dynamo)

Voir ce genre de modèle, par exemple, sur lequel travaille, entr'autres, Paul Charbonneau.

Pour ceux qui veulent se lancer dans une compréhension plus approfondie de la modélisation et en même temps du fonctionnement de la dynamo solaire on pourra se plonger dans cet article du même auteur.

On verra que c'est une science qui ne souffre pas de simplification abusive…

Les variations maximales, d'un maxi à un mini solaire, relevées avec les instruments embarqués, sont de l'ordre de 0.1%.

Le Soleil émet son rayonnement suivant le spectre du corps noir (grossièrement sans tenir compte des absorptions à certaines fréquences).

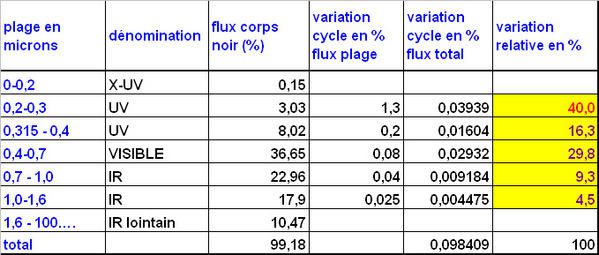

ci-dessous, la répartition du flux et de sa variation entre mini et maxi solaire:

on voit qu'une partie très importante, 40%, de la variation de flux, concerne les UV compris entre 0.2 et 0.3 microns (200-300 nm).

Une bonne partie de ce rayonnement (90% environ) étant absorbé par la stratosphère, on remarque que 70% environ de la variation de TSI due au cycle de 11 ans, rentre dans la troposphère.

Si on néglige la diffusion dans le reste de l'atmosphère, l'albédo imputable à l'ensemble troposphère + surface étant de 0.3 (autrement dit 30% du rayonnement réfléchi vers l'espace sans

absorption), c'est, grosso modo, 50% de la variation de TSI qui va être absorbée par l'ensemble troposphère + surface.

Si on ramène ce flux TOA au forçage radiatif il faut encore diviser par 4 le résultat.

Autrement dit, une variation typique de TSI de 1 W/m2, va engendrer un forçage sur troposphère + surface, de 0.122 W/m2.

Si on considère le couple "ensemble de l' atmosphère + surface", le forçage est de 0.175 W/m2.

Une telle variation, 0.5 millième du flux incident moyen, compte tenu, en outre, de l'inertie du système, est relativement faible si on la compare aux changements de flux saisonniers par

exemple.

Relativement à la puissance absorbée par la stratosphère la variation de TSI, 1.3% environ, qui concerne cette couche, est un peu plus significative, 26 fois plus que précédemment.

méthodes de mesures et de suivi de l'activité solaire

1- le nombres de taches

2 nombres normalisés:

- le nombre de Wolf, ou international sunspot number, est produit par le SIDC (Solar International Data analyse Center).

Sa valeur est:

R = K(10g+s)

où K est un coefficient relatif à l'observation (observateur, lieu, instrumentation,…)

g est le nombre de groupes de taches identifié (1 groupe comprend de 1 à n taches), s est le nombre total de taches.

nota: dans les tables apparaît le ssn qui est le spotnum lissé.

Il n'est donc pas évident de retrouver les spotnums journaliers à partir des photographies du soleil telle que celle du 7 janvier 2003 par exemple.(source spaceweather)

le spotnum brut est de 141, le ssn est de 90 seulement.

Mais on verra mieux la différence entre brut et lissé sur ce graphe du SIDC.

- le nombre de groupes de taches créé par Doug-Hoyt et Schatten, Rg, qui ne tient compte que du nombre de groupes de taches.

Sa valeur est :

Rg =1/N somme (12.08*gi)

où N = nombre d'observations, gi = nombre de groupes de taches par observation

le coefficient 12.08 est un coefficient de normalisation destiné à "coller" au nombre de Wolf.

Ces deux nombres représentent, selon les auteurs, un peu mieux l'un que l'autre certaines caractéristiques de l'activité solaire.

Ci-dessous, deux évolutions de l'activité solaire, la première, utilisant R, issue des données du SIDC, de 1700 à 2007.

fig(2)

La seconde, issue des données de NGDC/WDC, utilisant Rg, retrace l'évolution de 1610 à 1995.

Si cette seconde courbe présente l'avantage de nous donner un aperçu de la situation de l'activité pendant le minimum de Maunder, il faut toutefois, bien avoir conscience que les

données d'avant 1700 sont fortement soumises à caution.

remarque: si on fait l'hypothèse, réaliste, que l'amplitude maximum des cycles est, exprimée en W/m2, de l'ordre de 1.2W/m2, il apparaît que la

variation de TSI, mesurée par le nombre de taches (R ou Rg), entre le MM (Minimum de Maunder) et l'époque actuelle, est de l'ordre de 0.5-0.6 W/m2.

Ceci correspond à un forçage, très faible, de 0.1 W/m2 .

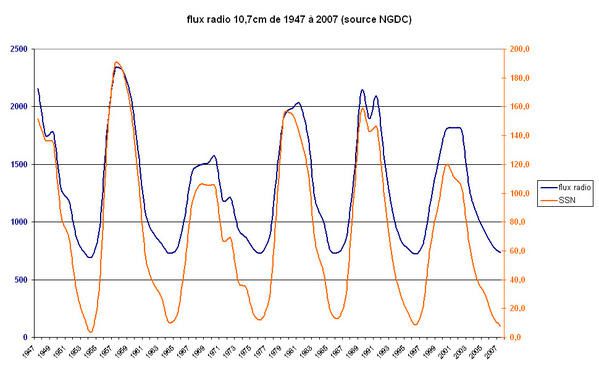

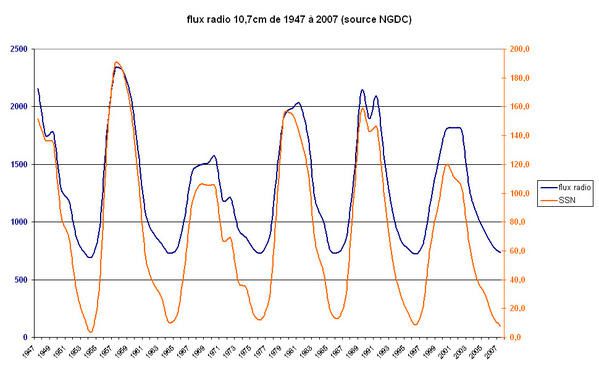

2- le flux radio à 10.7cm

ce flux suit très bien l'activité solaire et le nombre de taches en particulier.

fig4

il est à noter que si le nombre de taches peut tomber à zéro, il n'en n'est pas de même pour le flux radio.

Le niveau minimum correspondant à la l'activité de surface non perturbée.

Le coefficient de corrélation entre flux radio et SSN égal à 0.98, est évidemment excellent..

3- les rayons cosmiques

Le soleil émet, en permanence, le vent solaire.

Ce dernier est composé de particules chargées et d'un champ magnétique.

Les particules chargées émises à 400 km/s de la couronne solaire, ralentissent en rencontrant la matière interstellaire.

Le lieu où la vitesse de ces particules devient égale à la vitesse des particules interstellaires, s'appelle l'héliosphère

dont la forme plus ou moins sphéroïdale forme un genre de coque magnétique et de particules chargées, englobant le système solaire dans son entier.

Le vent solaire variant avec l'activité solaire, la "force" ou le rôle d'écran magnétique de l'héliosphère varie dans le même sens.

Les rayons cosmiques sont des particules chargées (protons) à très haute énergie, plusieurs Gev.

Ils sont émis à l'occasion de phénomènes cosmiques cataclysmiques et violents comme les explosions de supernovae, par exemple.

Ils ne viennent donc pas et en aucun cas, du soleil.

Malgré cette haute énergie qui se traduit par des vitesses relativistes, lorsqu'ils rencontrent le champ magnétique de l'héliosphère, ils sont plus ou moins déviés suivant la force du champ

magnétique.

La force qui s'exerce sur une particule de charge q, de vitesse v, dans un champ magnétiqueB est :

F = qv ^ B

En conséquence , lors des périodes de forte activité, moins de rayons cosmiques (GCR) rentrent à l'intérieur de l'héliosphère et par conséquent viennent toucher la Terre.

Lorsque ces GCR frappent notre atmosphère, ils ralentissent en formant des gerbes de particules de plus en plus

lentes, dont des neutrons.

Ce sont ces neutrons qui faisant l'objet de comptages sont donc représentatifs de l'intensité des GCR qui frappent la Terre et par là-même de l'activité solaire.

Moins de neutrons voulant dire plus d'activité solaire et plus de neutrons voulant dire moins d'activité solaire.

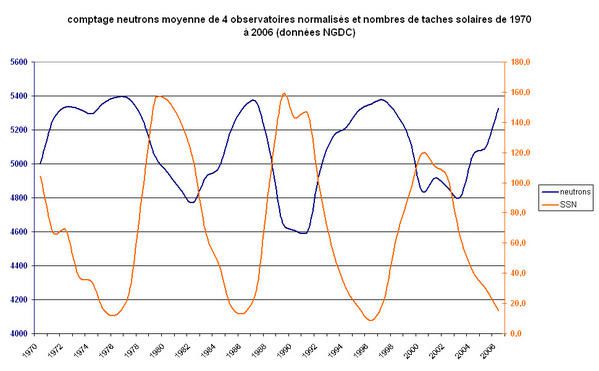

Les mesures neutroniques existent déjà depuis 5 décennies et sont réalisées par plusieurs observatoires de par le monde.

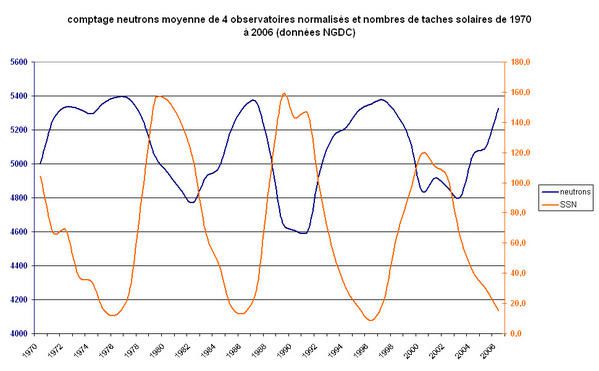

Nous avons réalisé un signal neutronique composite de 4 observatoires différents, Huancayo, Kiel, Moscou, Climax (voir les données NGDC).

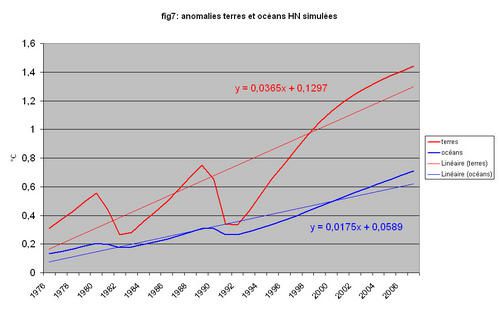

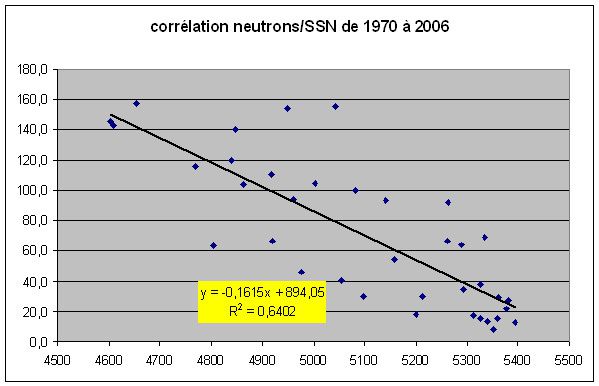

Le graphe ci-dessous représente le comptage neutronique de 1970 à 2006 (période commune des comptages) ainsi que le SSN.

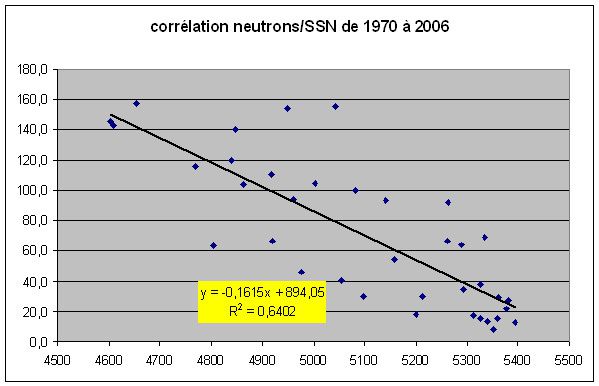

fig 6

on voit bien l'anti-corrélation entre les 2 signaux, quoique le coefficient de corrélation, égal à 0.64, soit moyennement bon.

fig7

Malgré tout le signal neutronique n'est pas à écarter comme mesure, approximative, de l'activité solaire.

4- les isotopes cosmogéniques

Les GCR (rayons cosmiques) qui rencontrent les noyaux des atomes de gaz atmosphérique, provoquent, soit directement, par spallation des noyaux d'azote, d'oxygène, ou Argon, le 10Be

(Beryllium 10), soit par capture de neutrons thermiques le 14C à partir de 14N.

Le 14C est généralement stocké dans les végétaux et notamment dans les cernes d'arbre où on peut mesurer sa teneur.

le 10Be est retrouvé dans les carottes glaciaires.

Comme les rayons cosmiques, qui passent au travers de l'héliosphère, varient avec l'activité solaire (modulation solaire), les teneurs en 14C et 10Be varient également.

Concernant le 14C, un problème important se pose à partir du 20ème siècle suite à l'utilisation des combustibles fossiles et, pire, suite aux essais nucléaires à partir de la fin de la

2ème guerre mondiale.

Pour le 10Be, il semble que sa teneur dans la glace dépende assez significativement du cycle hydrologique et du climat.

Un autre inconvénient à l'utilisation des isotopes est l'influence du géomagnétisme.

Cette influence implique, de plus, des variations suivant la latitude.

Nous avons vu, en outre, que les variations de flux de GCR ne reproduisaient qu'approximativement les variations de TSI et ne permettaient donc pas une reconstruction précise de la TSI.

Par conséquent, il nous semble difficile, pour le moment, d'utiliser ces proxies, pour décider définitivement de l'amplitude de la variation de l'activité solaire depuis le Minimum de Maunder par

exemple.

Il y a bien entendu de nombreux articles et études parus sur le sujet.

Les séries temporelles des isotopes sont relativement peu disponibles en libre accès, du moins en apparence.

ci-dessous une des rares séries trouvées concernant le 2ème millénaire de notre ère.

fig8

il s'agit de la variation de l'inverse du 10Be mesuré dans les carottes PS1 du pole sud comparée à la variation du GSN.

on remarque que si les 2 tendances évoluent, grossièrement, dans le même sens, le "détail" de la courbe GSN n'est que partiellement reproduit par la courbe isotopique.

5- le problème du "background"

les premières mesures de le TSI par satellite ont incité les scientifiques à étendre la connaissance de la TSI à la période pré- satellitaire en raccordant ces mesures avec le nombre de

taches solaires (SSN ou GSN), puisque ce dernier était connu depuis 1610.

D'un autre côté, les faibles variations de TSI trouvées par les satellites ne rendaient pas compte, selon eux, des variations climatiques de l'époque pré- industrielle, ou même de la première

moitié du 20ème siècle.

Ils ont donc été tentés de trouver une variation de TSI supplémentaire à la variation déduite des taches.

C'est cette variation supplémentaire qui a été désignée par Judith Lean (3), en particulier, comme le "background".

Ils (Baliunas) ont cru pouvoir mettre en évidence ce background en observant les étoiles semblables, ou les plus semblables, au Soleil.

En effet, certaines de ces étoiles, en situation de minimum de Maunder (MM) apparent, présentaient une activité magnétique plus faible que le soleil lorsqu'il est en minimum d'activité.

Depuis, Hall et Lockwood 2004 (4) en utilisant un échantillonnage supérieur d'étoiles, n'ont pas retrouvé la distribution bimodale trouvée notamment par Baliunas et Jastrow concernant les étoiles

"en activité" et les étoiles en MM.

Si des étoiles sont bien en activité plus faible, la majorité des étoiles en MM ont une activité égale et supérieure au Soleil en activité basse lors de ses cycles.

Il n'y a donc pas de raison objective de privilégier l'hypothèse basse pour tenter d'expliquer des variations climatiques supposées du moins supposées en amplitude.

Les reconstructions de Lean 1995 et 2004, montrent les différences importantes entre les delta de TSI suivant la prise en compte ou non, du background.

D'autres hypothèses concernent la présence d'un background faisant intervenir les évolutions des isotopes et du géomagnétisme.

voir chapitre 2 AR4 p190.

Cependant les travaux de Wang 2005 (5), notamment, comprenant l'introduction d'un modèle de transport de flux magnétique, réfutent la présence d'un tel background.

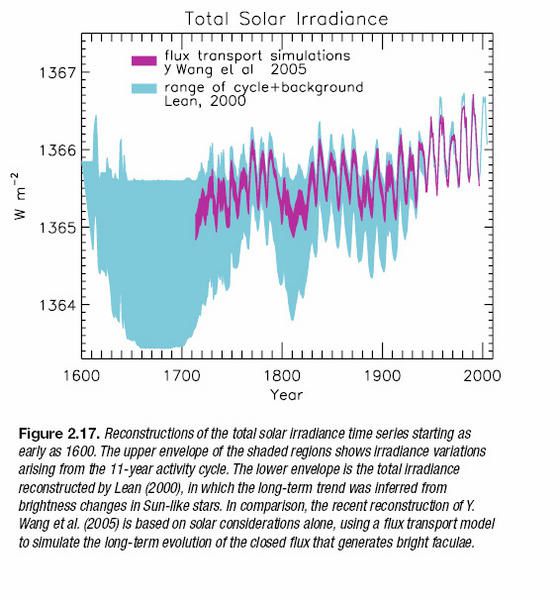

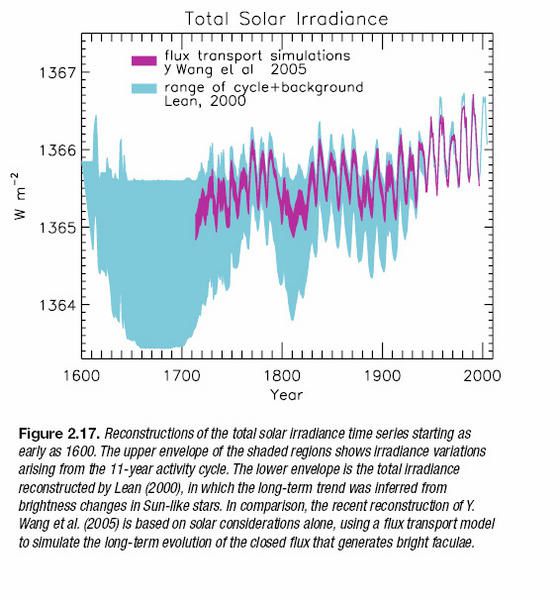

Voir ci-dessous la reconstruction, extraite de AR4 chap 2 p190, de la TSI de Wang 2005.

Cette reconstruction laisse apparaître un delta MM/ contemporain de 1W/m2, alors que le delta 2000-1900 est de 0.5W/m2.

Rappelons que ces variations de TSI correspondent à des forçages TOA respectivement de 0.175 et 0.087 W/m2.

6- les relevés satellitaires

il s'agit de la mesure, en direct, de la TSI.

L'appareillage utilisé est du type radiomètre comme le TIM utilisé dans le projet SORCE.

Malheureusement et contrairement à ce que l'on pourrait croire, les mesures de TSI depuis 1978, date de la mise en orbite du premier satellite destiné à mesurer l'activité solaire, sont très

dispersées.

Voici le graphique des mesures effectuées par les satellites depuis 1978 ainsi que les 3 reconstructions ACRIM, PMOD, et IRMD.

fig11

Nous ne développerons pas outre mesure la polémique entre ACRIM (Wilson) et PMOD (Frölich) au sujet de minimum du cycle 22 plus élevé de 0.4W/m2 pour ACRIM que pour PMOD.

Simplement la reconstruction ACRIM se targue d'être la meilleure car utilisant les "véritables" données (voir la dispersion), dont la calibration est loin d'être assurée, alors que PMOD essaie de

corroborer ces données avec d'autres proxies et les modèles de reconstruction de TSI à partir des taches et des facules.

Il est bien clair que le SSN, les modèles, le flux radio, le flux neutronique ne corroborent pas un minimum 22 aussi élevé.

On lira le chapitre 2 de l'AR4 page 189, à ce sujet.

On notera en outre que SORCE, qui constitue le projet le plus récent et le plus "up-to-date" , se situe à 4.5W/m2 en moyenne, en dessous de ACRIM3 et VIRGO pour des raisons encore en cours

d'étude.

Les résultats de TSI sont dispersés sur 1% environ alors que l'on cherche une précision de l'ordre de 0.01%.

Ceci ne voulant pas dire que l'on ne peut corréler tous ces enregistrements, bien sûr, pour obtenir une tendance fiable, mais il reste une inconnue sur la valeur absolue exacte.

les espoirs actuels des scientifiques se portent désormais sur SORCE.

INFLUENCE SUR L' EVOLUTION CLIMATIQUE du 20ème siècle

1- le problème de l'amplitude de la variation de TSI

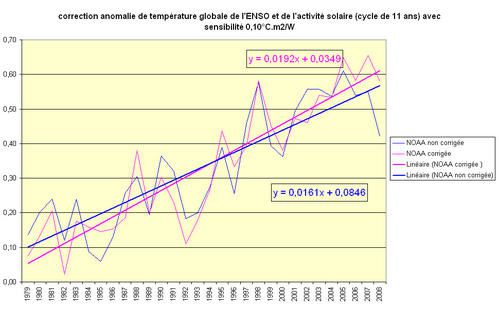

Nous utilisons l'évolution de la TSI de Wang 2005 (5) ainsi que les valeurs du cycle sans background de Lean 2004.(3)

voici ce que donne cette évolution:

fig 12

la variation entre 1713 et 2007 est de l'ordre de 1 W/m2, ce qui correspond à un forçage de 0.175W/m2.

On notera que ce forçage, qui prend en compte toutes les longueurs d'onde, est un peu supérieur à la "meilleure estimation" du GIEC, soit 0.12W/m2.

On notera également la valeur assez basse de la TSI en 2007.

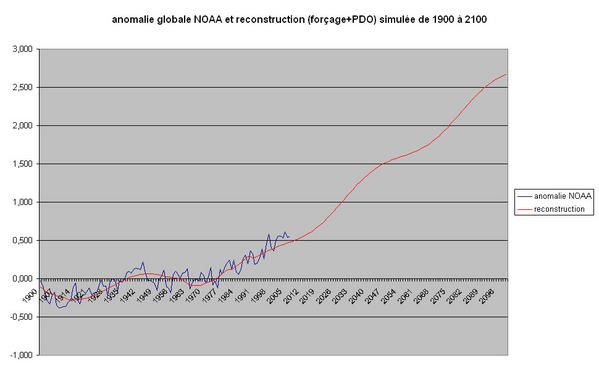

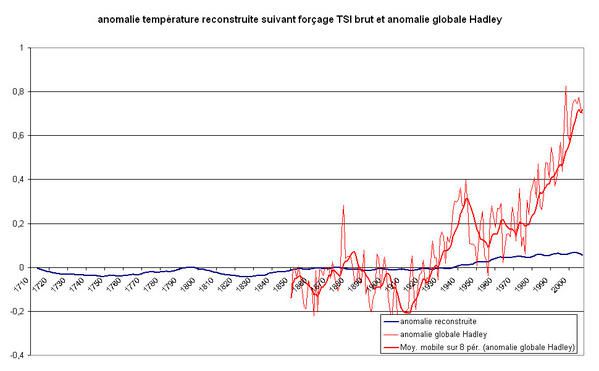

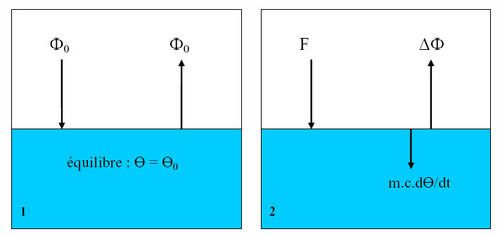

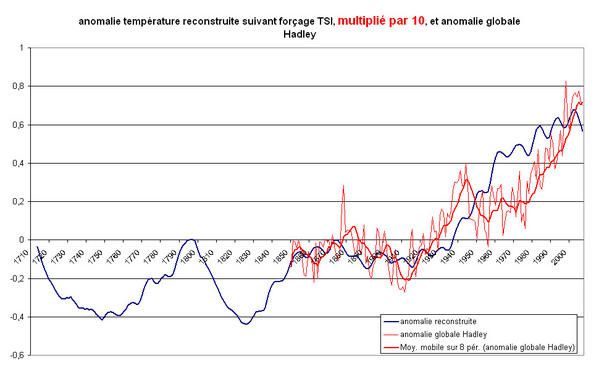

Nous allons maintenant reconstruire l'évolution de l'anomalie théorique de température, si le forçage solaire était le seul à agir.

Nous utilisons pour ce faire le "modèle" décrit dans l'article "anomalie de température et inertie thermique" sur ce même site.

La hauteur d'eau équivalente est prise égale à 230 m, ce qui correspond à la HEE de 300m de 1955 à 2003 calculée dans l'article, pour l'océan global, et la HEE de 80 m environ pour les terres,

avec les hypothèses prises sur les forçages et sur les valeurs Levitus.

Bien entendu, nous avons conscience que cette HEE serait fortement différente si les forçages réels étaient fortement différents.

voici donc ce que donne cette reconstruction mise en perspective avec l'évolution de la température selon Hadley.

fig 13

la valeur de l'anomalie due au soleil est à peine de 0.1°C sur les 0.8°C mesurés et on voit que même la période 1910-1940 n'est pas entièrement explicable, loin s'en faut, par l'évolution

solaire.

on peut remarquer aussi la très faible amplitude de l'oscillation due au cycle de 11 ans, inertie thermique oblige.

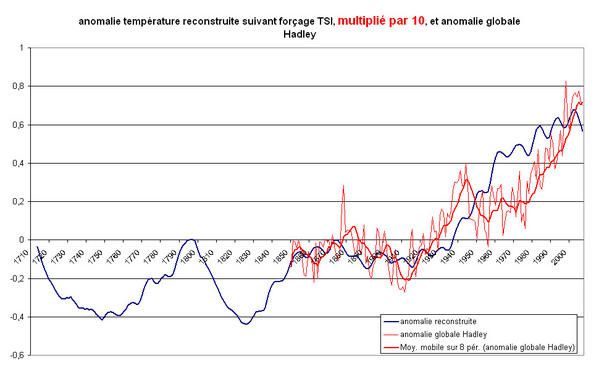

Pour avoir une évolution qui ressemble à l'évolution réelle, il faudrait multiplier le forçage par un facteur 10.

fig 14

Bien entendu, on pourrait aussi avoir toutes les valeurs comprises entre 1 et 10 si on associe ce forçage avec d'autres forçages, anthropiques et volcaniques, notamment.

Il est donc clair que, pour accorder une importance significative au Soleil, dans l'évolution actuelle, il faut trouver un forçage supplémentaire, important, qui accompagne l'évolution du

forçage solaire brut.

Ce forçage n'est pas à considérer comme une rétroaction positive de la température et donc ne fait pas intervenir la sensibilité climatique au sens habituel du terme.

2- l'action des rayons cosmiques sur les nuages

Marsh et Svensmark sont à l'origine de cette hypothèse qui est fortement controversée, cela va sans dire.

Mais venons en à l'hypothèse.

Nous avons vu que les rayons cosmiques variaient en sens inverse de l'activité solaire.

Ces rayons cosmiques sont suspectés, par les tenants de la théorie, provoquer, dans la basse troposphère, des nucléations de gouttelettes d'eau, à l'origine des nuages.

C'est le principe de la chambre de Wilson (à vapeur saturante) qui permet de détecter les trajectoires de particules (nucléons par exemple) issues de collisions.

La théorie prévoit, dans sa dernière mouture, que l'action des rayons cosmiques se fera sentir dans la formation des nuages de basse altitude (gerbes de particules en forme parapluie), les

stratus notamment.

Comme ces nuages ont un effet d'albédo fort pour un effet de serre quasi-nul, le raisonnement est :

activité solaire basse => GCR forts => plus de nuages bas => plus d'albédo => baisse de la température globale accentuée.

Le raisonnement est simple, mais il se tient.

Alors pourquoi n'est-il pas plus pris en considération?

Nous allons essayer de tirer quelques courbes et comparaisons à ce sujet.

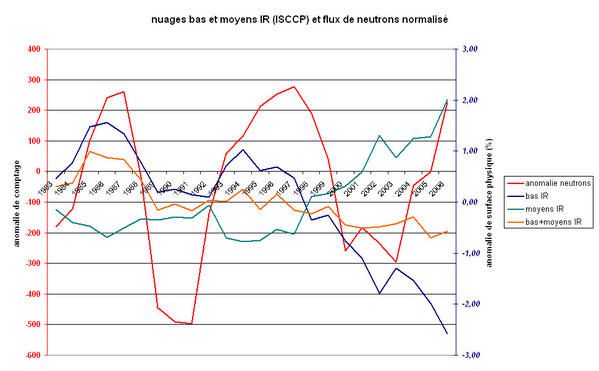

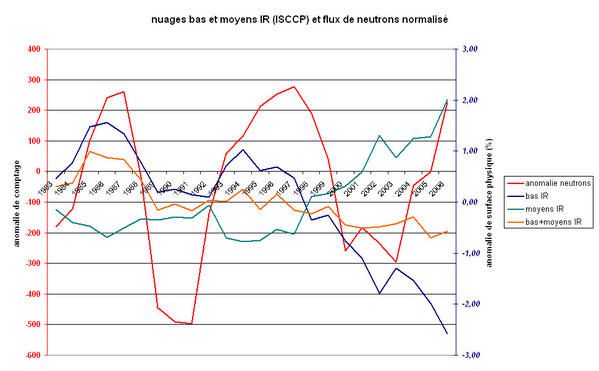

Nous utiliserons les comptages neutrons normalisés, suivant plus haut, et la base de données sur les nuages ISCCP.

Regardons tout d'abord les nuages bas observés en visible.

fig 15

il apparaît , que la corrélation des données brutes est non significative, R2 = 0.0006, pour ce qui concerne le visible et sur l'ensemble de la période.

Elle s'améliore un peu cependant si on réduit cette période qui déjà n'est pas très longue, 26 ans, climatologiquement parlant.

La corrélation semble meilleure lorsqu'on regarde les nuages bas en IR.

fig 16

cette corrélation passe à 0.06, et quoique peu signicative, s'améliore d'un facteur 100 par rapport aux nuages bas visibles (NBVI)

Elle est d'ailleurs bien meilleure sur les 2 premiers cycles, mais la fin de la courbe ne confirme pas.

Ajoutons maintenant à la courbe précédente, les nuages de niveau moyen (NM) ainsi que la somme NMIR et NBIR.

fig 17

il apparaît une chose assez étrange qui mériterait approfondissement.

En effet, la courbe des nuages moyens semble la symétrique, moins prononcée sur le premier cycle, de la courbe des nuages bas.

commentaires sur ces courbes et pistes de réflexion

On constate que la corrélation entre nuages bas et activité solaire n'apparaît que pour l'IR.

On pourrait objecter que le visible est soumis au parasitage du volcanisme (voir Pinatubo en 1992) mais, malgré ce point, la corrélation reste très mauvaise.

nota: El Chichon, en 1985, peut masquer également les nuages bas, mais cela ne change pas la corrélation puisque ça va dans le même sens.

Concernant l'IR, la corrélation est effectivement meilleure sur les 2 premiers cycles, mais le fait que les nuages moyens diminuent quand les nuages bas augmentent, semble peu explicable

physiquement en tous cas par les GCR.

On peut penser plutôt à un biais de la mesure qui prend des nuages moyens pour des nuages bas.

Si c'est le cas, la corrélation s'effondre complètement.

Mais il y a peut-être une explication physique à rechercher dans la convection quoiqu'il faudrait expliquer que tous les nuages bas (dans le 2 ème cycle) nouvellement formés, empêchent les nuages

moyens de se développer.

Cela ne paraît pas très vraisemblable.

Il est également très étrange de constater, que, alors que l'influence supposée des nuages bas se produit uniquement dans le domaine visible, la corrélation soit absente dans ce

même domaine.

De plus la détection des nuages bas en IR peut sembler un peu délicate étant donnée la température, très proche de la température de surface, du sommet des nuages bas.

En dehors des fluctuations dont nous venons de parler, la tendance à la baisse des nuages bas dans le visible, est très forte, de l'ordre de 4% entre 1983 et 2006.

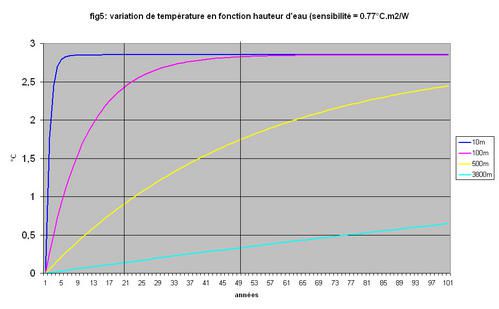

Un petit calcul permet de corréler la baisse de 1% des nuages bas au forçage.

Ce forçage est de l'ordre de 1.3 W/m2 par % de hausse.

En admettant une valeur de sensibilité de 0.77°C.m2/W cela nous mène à une augmentation de température de 4°C à l'équilibre et pour tenir compte de l'inertie thermique, de l'ordre

de 1.5°C en 2006 par rapport à 1983.

La base Hadley nous donne 0.5°C seulement.

On pourrait dire également, que la forte baisse des nuages bas est compensée par la hausse des nuages moyens, mais ces nuages moyens sont considérés comme neutres d'un point de vue forçage, leur

effet d'albédo équilibrant leur effet de serre.

Donc si ce trend était réel il se verrait forcément dans des anomalies de température très élevées.

Ceci n'étant pas le cas, il peut sembler alors que les mesures de nuages, manquent de fiabilité et que les résultats que l'ISCCP nous livre, soient à prendre avec une extrème

précaution.

On lira ce que pense le GIEC, non pas de l'ISCCP, mais des rayons cosmiques, toujours au chapitre 2 de l'AR4 p193.

principalement:

-la non justification d'un détrending opéré par Svensmark

-le pb visible/IR

- l'absence de tendance sur les anciennes bases de données de nuages

- le fait que des influences locales (RU) soient équilibrées par des tendances locales inverses (USA)

-le fait que les variations solaires en elles-mêmes peuvent provoquer des changements dans la convection

-la variabilité décennale interne

-l'influence de l'ENSO

3- les autres phénomènes climatiques induits

Nous avons vu au début de cet article que 30 % environ de la variation de TSI affectait la stratosphère directement.

Le changement de "chauffage" de cette dernière étant de l'ordre de 1% entre un maxi et un mini solaire, il ne faut pas attendre à priori de bouleversements émanant de cette couche.

Il semble cependant, selon de nombreux auteurs, que le signal du cycle de 11 ans soit, sur les températures de surface, de l'ordre de 0.1°C, alors qu'il devrait être 5 à10 fois inférieur

si on ne tenait compte que de l'effet radiatif combiné à l'inertie du système.

Il semble également que l'origine principale de cette variation forte soit une modification des interactions stratosphère / troposphère, engendrée par une variation du chauffage de la

stratosphère, et donc une modification de la circulation atmosphérique qui affecte directement notre climat.

Certaines études parlent même d'une modification de la circulation océanique, engendrée par les mouvements de l'amosphère, l'ENSO par exemple.

Ces mécanismes, certainement très complexes, ne sont pas encore bien identifiés et expliqués, mais une rétroaction positive provenant de stratosphère paraît assez probable si on en

croit les centaines ou milliers d'articles à ce sujet.(6)

conclusion générale

Nous avons exploré quelques uns des moyens d'évaluation de l' activité (TSI) solaire concernant les quatre derniers siècles.

Nous avons vu que cette activité était très fortement corrélée à l'activité magnétique du soleil et que, le background n'étant pas prouvé, sa prise en compte n'était pas justifiée.

Ceci nous a conduit à envisager comme probable une variation de l'ordre du Watt/m2 de la TSI depuis le minimum de Maunder et donc comme probable une variation du forçage solaire de l'ordre de

0.175 W/m2.

Cette variation n'ayant qu'un effet très faible sur la température globale, de l'ordre de 10% de l'évolution constatée depuis 1850, il a fallu envisager le "recours" à des forçages "supplétifs".

Parmi ceux-ci le forçage par les nuages, via les rayons cosmiques, semble, pour le moment, plutôt ne pas passer le cap des simples corrélations visuelles, du moins sur une période suffisamment

longue et dans un contexte (nuages moyens et problème du visible) cohérent.

Il reste donc, de la part de ses promoteurs, à exploiter les résultats de l'expérience CLOUD (7) et à passer à une théorie plus structurée.

Les influences de l'activité solaire sur la stratosphère n'ont été qu'effleurées car non précisément connues.

Mais on peut en déduire, pour le moment, que l'hypothèse d'un réchauffement climatique récent, principalement d'origine anthropique et, secondairement, solaire, est la plus probable.

références et liens

(1) NASA Solar physics

(2) Variations in solar luminosity and their effect on the Earth's climateP. Foukal1, C. Fröhlich2, H. Spruit3 and T. M. L. Wigley4

(3) Lean, J.. 2004.

Solar Irradiance Reconstruction.IGBP PAGES/World Data Center for Paleoclimatology

Data Contribution Series # 2004-035.

NOAA/NGDC Paleoclimatology Program, Boulder CO, USA.

(4) THE CHROMOSPHERIC ACTIVITY AND VARIABILITY OF CYCLING AND FLAT

ACTIVITY SOLAR-ANALOG STARS

Jeffrey C. Hall and G. W. Lockwood

(5) MODELING THE SUN’S MAGNETIC FIELD AND IRRADIANCE SINCE 1713

Y.-M. Wang, J. L. Lean, and N. R. Sheeley, Jr.

(6) DECVAR

(7) cloud experiment