(voir EDIT du 05 août en fin d'article)

Les sceptiques, en plus de nier le réchauffement actuel et/ou de nier son origine, ont pour fâcheuse habitude de rabaisser son amplitude au regard d' hypothétiques réchauffements du passé.

On connaît tous le fameux Optimum Médiéval, sensé avoir fait reverdir le Groenland, et avoir permis sa colonisation par Eric le Rouge sans oublier le vin en Angleterre, voire en Ecosse etc.

Fameux optimum dont l'amplitude bien supérieure au réchauffement actuel a été "mise en évidence" par le célèbre Beck, falsificateur sceptique (pléonasme?) de son état.

Tout est bon pour servir de pâture au peuple sceptique de base qui refuse, par idéologie conservatrice, l'idée même d'un réchauffement anthropique global, car, comme pour ce triste sire d'Inhofe:

"Tant que la terre subsistera, les semailles et la moisson, le froid et la chaleur, l'été et l'hiver, le jour et la nuit ne cesseront point." …"Dieu est toujours là-haut. Je suis scandalisé par l'arrogance des gens qui pensent que nous, êtres humains, serions capables de changer ce qu'Il fait avec le climat."

source: Passeur de sciences

Venons en au Groenland.

Ceux qui s'intéressent aux "arguments" sceptiques, connaissent celui qui évoque la variabilité de la température de surface du Groenland mise en exergue par les températures de GISP2 (45000ans de données).

Ces températures sont déduites du déficit en O18 des échantillons de glace prélevés par carottage dans l'inlandsis au "summit" du Groenland.

Alors on vous montre ce genre de courbe ci dessous (je résume car on vous le distille savamment en plusieurs étapes censées vous impressionner de façon faussement pédagogique) :

Comme vous le voyez le réchauffement actuel est dérisoire par rapport aux différentes pointes de chaleur précédentes.

Ciel!

Beck le falsificateur aurait-il finalement raison?

Bon, aller, on va "débunker" tout çà.

1- "before present"

Oui le dernier point de la courbe ci dessus, la fin du "réchauffement moderne", c'est en fait en 1854.

Car en paléo, puisque, le présent change à chaque seconde, le présent, c'est le 1er janvier 1950, par convention.

Comme le premier point de la base de Alley est 0.0951 ky BP, c'est un échantillon qui correspond à 1854.

Mais pour les sceptiques, c'est çà le réchauffement moderne.

2- La base de données Alley 2000.

Bon, c'est tout de même un peu gênant qu'il n'y ait pas les incertitudes.

En général, çà se donne, dans une vraie publication.

Si on regarde la figure 3 de Jouzel 94, même si on prend la courbe du bas LGM, pour un même δ 18O, l'incertitude sur la température est de +-5°C.

On peut certes admettre que statistiquement l'incertitude se réduit, soit, mais tout de même, utiliser des mesures aussi imprécises pour gloser sur un optimum médiéval d'amplitude 2°C, il faut le faire.

Alors en fait ce n'est pas tant la mesure isotopique elle-même qui est en cause, mais, entre autres, la composition changeante des différentes sources de vapeur d'eau qui va précipiter au-dessus du "summit".

Il y a bien sûr d'autres sources d'incertitudes et il faut être très prudent pour utiliser ce genre de courbe bruitée, mais les sceptiques, n'y connaissant strictement rien, s'en balancent éperdument.

Mais allez, soyons bon prince, utilisons tout de même cette belle courbe de GISP2.

3- la variation de l'insolation.

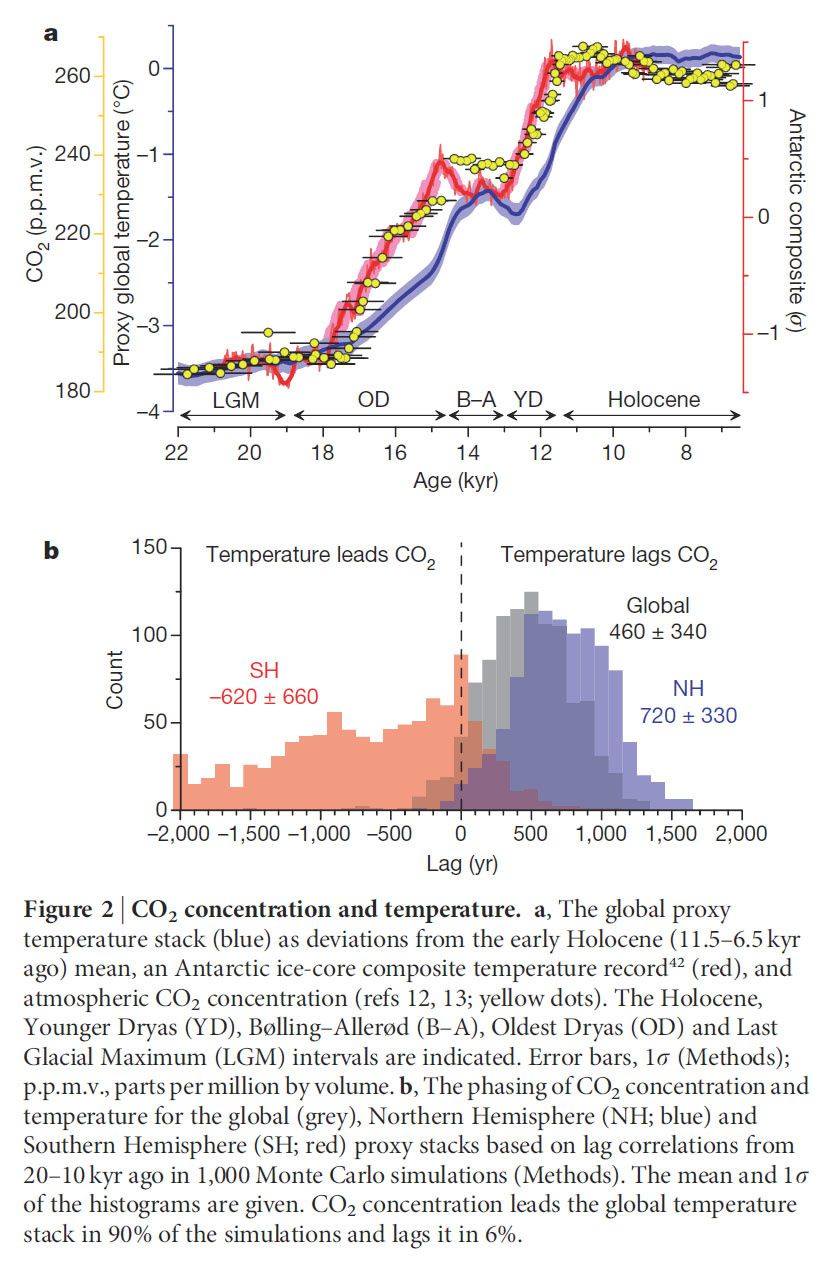

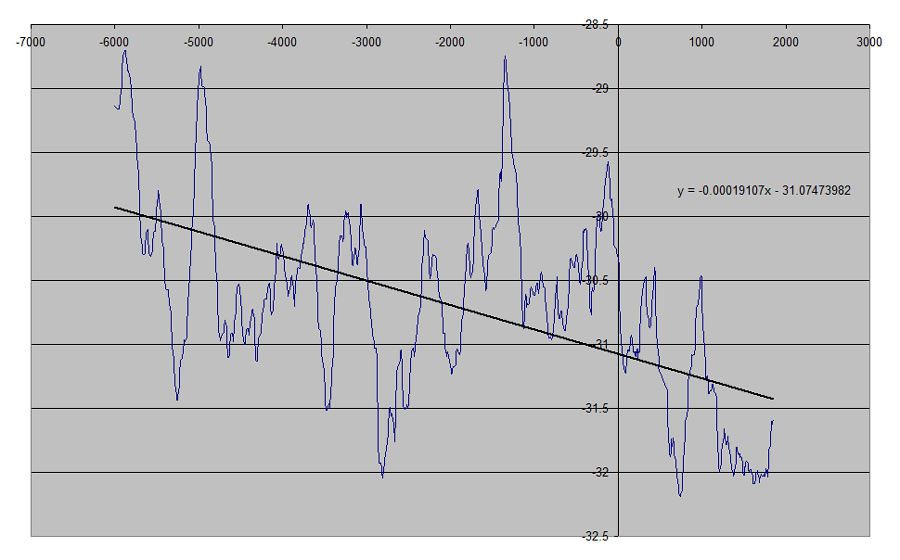

Eh oui, comme vous le savez tous, l'insolation baisse régulièrement sur le Groenland (et dans l'Arctique en général) depuis le milieu de l'Holocène.

Il suffit donc de tracer la régression linéaire de la courbe plus haut sur 8000 ans pour s'apercevoir que, la température baisse d'environ 0.2°C/millénaire (+- quelque chose étant donné l'incertitude vue plus haut).

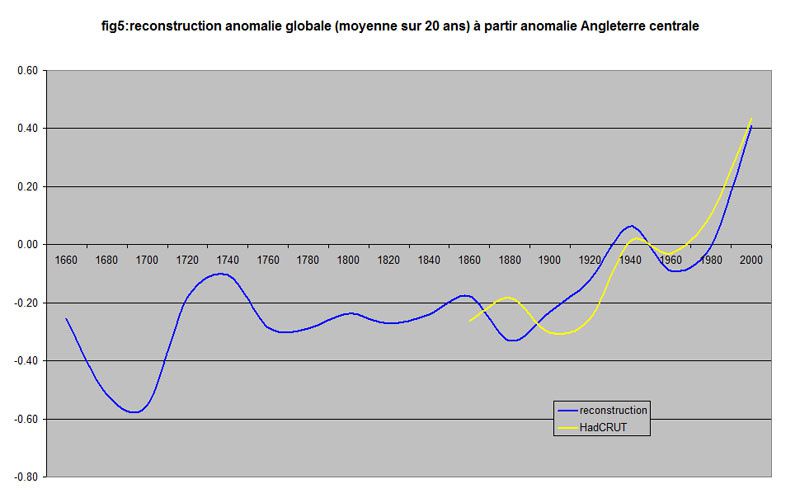

Si on veut comparer à ce qui se passe maintenant, à insolation équivalente donc,il faut donc détrender la courbe, ce qui donne:

Bon çà n'a pas tout à fait la même allure, non?

Mais enfin le réchauffement moderne n'est pas encore terrible.

4- la vraie période moderne

Ah ces données de BEST, elles sont géniales.

Bon, elles ont aussi une incertitude mais comme l'incertitude on s'en fiche puisqu'on utilise tel quel Alley 2000, allons-y.

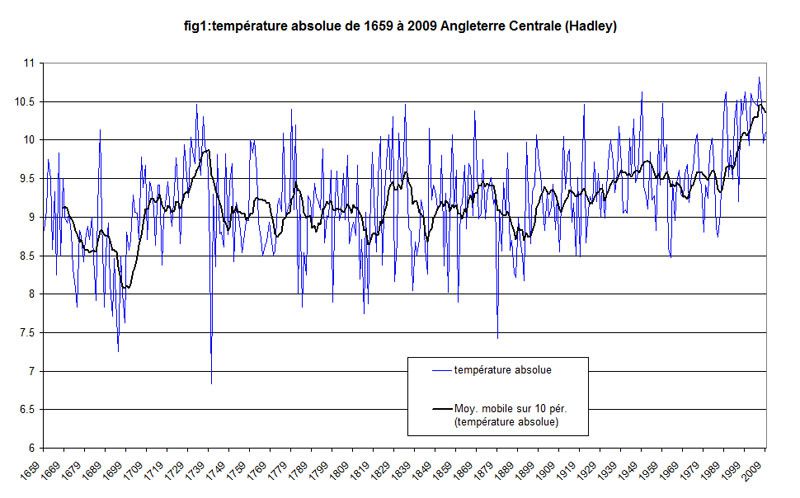

Voici tout d'abord la courbe de BEST pour le Groenland.

Je sais pas comment ils ont fait pour les valeurs anciennes mais admettons.

On va rabouter les deux courbes, en standardisant à partir de leurs données communes, ce qui n'est pas évident étant donné, répétons le, les incertitudes.

Ah c'est déjà mieux, mais c'est nettement moins bien pour un sceptique, je le reconnais.

La courbe rouge est la moyenne glissante sur 10 ans de la série BEST, mais Alley doit être plus lissée.

C'est de plus la moyenne du Groenland alors qu'Alley c'est pour le "summit" uniquement ce qui fait que la variabilité peut être plus importante pour ce point mais ce n'est pas évident sur de longues périodes.

Il n'empêche que le vrai réchauffement moderne du Groenland semble tout fait significatif par rapport aux différents "réchauffements" de Alley.

causes des variations de température

Evidemment, si on n'a pas l'amplitude exacte des variations ce n'est pas facile d'en donner les causes, sans compter l'erreur sur le temps.

On peut seulement supposer que le Groenland est particulièrement sensible aux oscillations océaniques de l'Atlantique nord, mais les variations passées ne semblent pas être de même période (60 à 80 ans) que l'AMO mais plutôt de l'ordre de plusieurs siècles, voire du millénaire.

Le phénomène suspecté de "sea-saw" entre Antarctique et Arctique aurait une période de 2000 ans et pourrait peut-être détecté dans la série de Alley?

D'autres candidats comme les volcans, l'activité solaire, peuvent influencer et il y a peut-être conjonction de plusieurs effets.

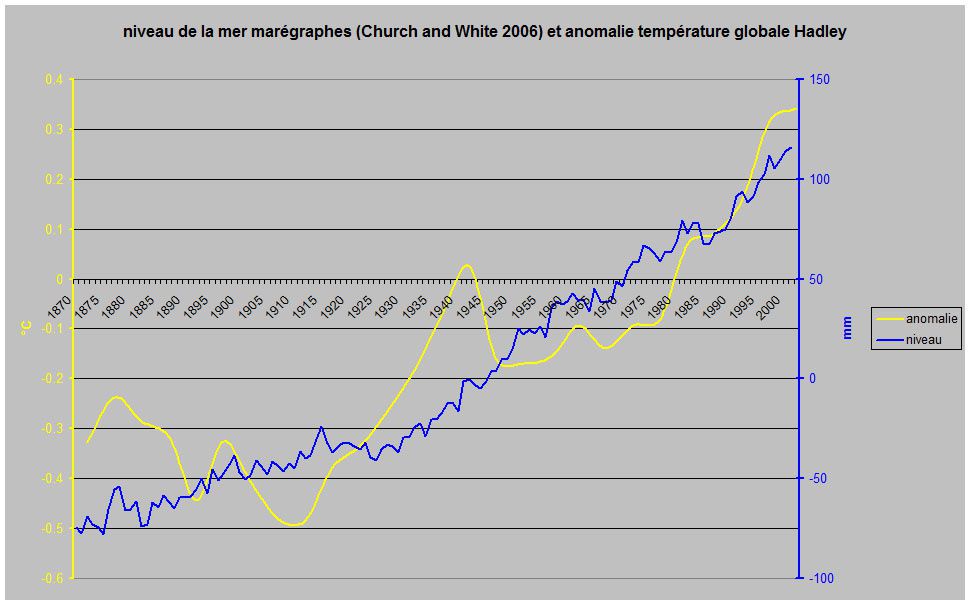

Pour le réchauffement actuel, on ne peut évidemment pas oblitérer le rôle anthropique, de par les GES évidemment mais aussi de par les aérosols carbonés qui ont pu avoir une grosse influence au début du 20ème siècle.

Lorsqu'on a une augmentation de la température moyenne et une augmentation encore plus forte des températures les plus élevées, il est assez évident, ou de bon sens, que les phénomènes de fonte généralisée comme on les a vus récemment, deviennent de plus en plus fréquents.

Et dans les deux derniers millénaires, il est possible, oui, qu'ils soient exceptionnels.

EDIT du 05 août 2012 à 14H40

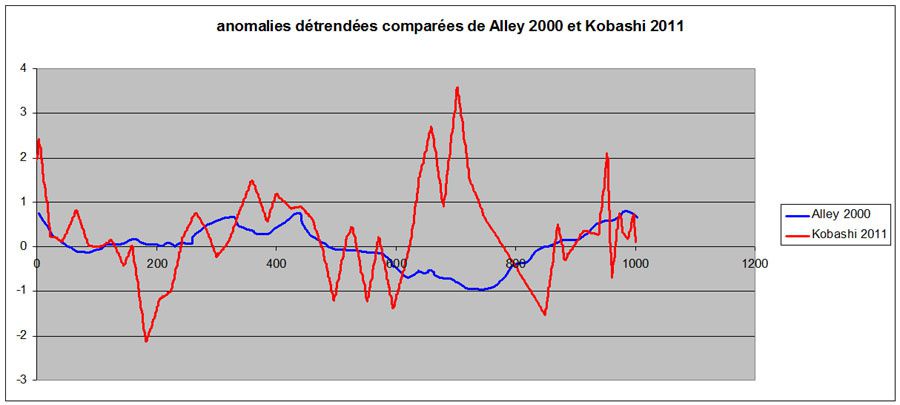

On lira avec intérêt cette étude de Kobashi 2011 qui reconstruit les températures de surface de la neige au "summit" du Groenland.

Elle est basée sur les isotopes de l'Argon et de l'azote, piégés dans les bulles d'air de la glace.

On est donc cette fois indépendant des sources et la méthode devrait être plus précise.

L'incertitude annoncée est de l'ordre de +-0.5°C.

Là aussi il y a "raboutage" avec les températures mesurées T2m près du summit.

Le problème étant que le T2m est plus chaud que la Ts de la neige (inversion de très basse couche)

Les températures actuelles sont abaissées de 1.75°C par comparaison entre les parties communes.

c'est peut-être là, d'ailleurs, que le bât blesse.

Quoiqu'il en soit, voici les résultats "bruts" tels que figurés sur la fig 1 de l'étude.

Comme on peut le constater, la hausse moderne de la température du Groenland est très relative par rapport à beaucoup de hausses passées.

La température de 2010 devient comparable à ces plus fortes hausses et il faut se rappeler que le Groenland bénéficiait d'une insolation plus forte que l'actuelle dans le passé.

Les différentes méthodes isotopiques donnent des résultats quelquefois très contradictoires, voir par exemple le fort réchauffement vers 700 de Kobashi et le refroidissement correspondant chez Alley.

Ce dernier point ainsi que les méthodes de raboutage de données T2m et de température de neige, la représentativité de la température du summit avec la moyenne du Groenland, etc., doivent amener à considérer, comme d'habitude, ces résultats avec prudence.