voir ici le développement

voir ici le développement

Il semble qu'une certaine tendance du moment soit une révision, à la baisse, de la sensibilité climatique.

Cette dernière mesure l'augmentation de température globale suite à un doublement de la teneur en CO2.

On nous avait inculqué, depuis une dizaine d'années, qu'une valeur médiane de l'ordre de 3°C était la plus probable.

J'ai le sentiment qu'on se dirigerait maintenant vers une sensibilité autour de 2°C.

Rappelons que la sensibilité est calculée de trois façons principales:

- par les modèles

- en analysant les périodes glaciaires,

- par les observations de la période contemporaine.

Pour les modèles, il y a le problème bien connu des nuages dont on doit paramétrer les effets alors qu'on les connaît encore assez mal.

Je n'ai pas les résultats des modèles récents à part peut-être le GISS CMIP5 qui donnerait 2.5°C (voir le commentaire 11)

Pour les périodes glaciaires on n'est certain ni des températures ni des forçages.

En ce qui concerne les observations, le modèle simplifié que j'utilise, comme indiqué dans un article précédent, calcule une sensibilité d'environ 1.8°C.

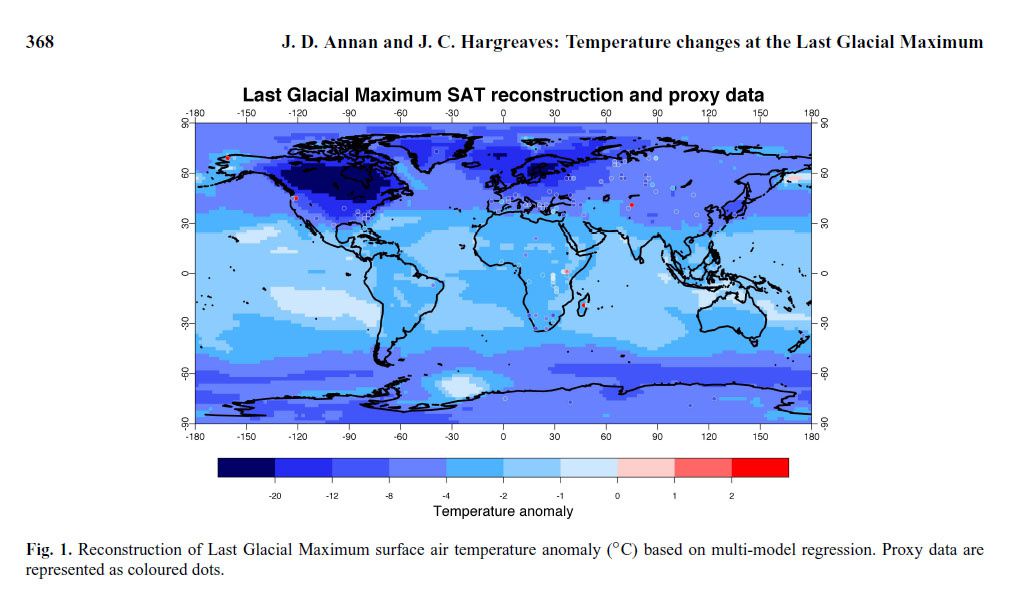

Côté paléoclimatique cette étude très récente de Hannan-Heargraves indique une sensibilité moyenne de 1.7°C.

Le refroidissement global moyen lors du dernier maximum glaciaire (LGM) est estimé à 4.0+-0.8°C alors que les estimations de forçage sont de 6 à 11W/m2.

Ceci conduisant à une fourchette de sensibilité, selon les auteurs, de 1.2 à 2.4°C avec 1.7°C comme valeur la plus probable.

Bien que ce résultat est considéré comme peu robuste (non linéarité et asymétrie), il constitue une brèche remarquable dans le consensus des 3°C.

Je ne sais personnellement pas quelle est la valeur de la sensibilité.

Les infos contenues dans l'AR5 "fuité" m'ont conduit à estimer qu'elle est de l'ordre de 1.8°C mais c'est à confirmer puisque l'AR5 définitif n'est pas publié.

Quelles seraient les implications d'une sensibilité aussi basse?

Difficile d'être précis, mais on peut supposer que les problèmes économiques liés à la disponibilité de carbone fossile prendraient plus nettement le pas sur des conséquences climatiques d'avantage diluées dans le temps.

Conséquences qui seraient d'autant moins fortes qu'elles nous laisseraient d'avantage de temps pour nous adapter.

Ce serait donc, in fine, une excellente nouvelle.

D'aucuns d'entre vous auront été, je pense, interloqués en lisant la presse ces temps-ci.

Par exemple, dans le Parisien, on pouvait lire, il y a tout juste une semaine:

"+4°C en 2060: le "cataclysme" climatique vu par la Banque mondiale"

Evidemment 4°C de plus par rapport à l'époque industrielle, alors que nous en sommes, en 2012, à 0.85°C, çà peut interpeler.

Mais qu'est-ce qui a pu changer pour que, d'un seul coup, on parle de 4°C alors qu'on s'était habitué, pour certains difficilement, au seuil des 2°C?

En fait, rien du tout, et pour s'en convaincre il faut se procurer le rapport en question.

Déjà le titre est différent de ce qu'en a retenu la presse:

"Turn down the heat

Why 4°C warmer world must be avoided?"

Je me suis focalisé sur le paragraphe 3, "How likely is a 4°C world?", car, en ce qui concerne les conséquences, il est difficile de détecter, dans ce rapport assez léger, un quelconque cataclysme en 2060 et même en 2100.

Sont simplement (si j'ose dire) évoquées les sécheresses, les augmentations de puissance des ouragans les plus forts (avec doublement du coût des dégâts) et du niveau de la mer.

Mais revenons-en à cette probabilité des 4°C.

Tout vient en fait du couple "scénario d'émissions/sensibilité climatique" décliné dans la figure 21.

La zone grisée représentant 66% de probabilité on peut donc dire qu'il y a 17% de chance que la température dépasse 4°C dans le cas du scénario d'émissions RCP8.5.(si la distribution de probabilité est symétrique) vers 2060-2070.

Le RCP 8.5 se situe entre les anciens scénarios SRES A2 (8.07W/m2) et A1FI (9.14W/m2).

Il se caractérise par une forte intensité carbonée de l'économie pendant tout le 21ème siècle.

Les émissions de CO2 issues de la combustion du carbone fossile (pétrole, gaz naturel, charbon) atteignent 28.7Gt/an en 2100, menant à une concentration de CO2 dans l'atmosphère de 1231ppm (en CO2 équivalent) contre 398ppm actuellement (*1).

Le forçage radiatif total est de 8.34W/m2 en 2100 dont 6.51W/m2 pour le seul CO2.

Il ne m'appartient pas de dire si ce scénario est réaliste ou pas.

Si on considère les ressources de carbone fossile:

source GAC page 114

(attention les quantités sont exprimées en CO2, multiplier par 0.2727 pour avoir en C)

et une progression de la technologie comparable à ce que nous connaissons depuis la seconde moitié du 20ème siècle, ce scénario est possible.

Le cumul des émissions de CO2 de 2013 à 2100 est de 1856GtC ce qui est supérieur aux réserves connues (1500Gt de conventionnel + non-conventionnel) mais très inférieur au montant des ressources estimées (13000Gt) sans parler des "further occurences" (8500Gt).

Dans le petit développement qui suit, nous envisagerons également le scénario RCP6, que certains pourront juger plus vraisemblable, afin de donner une fourchette, non exhaustive, des possibles.

Les émissions de CO2 de 2013 à 2100, pour le RCP6 sont de 1160GtC ce qui est inférieur aux réserves connues.

Concernant la sensibilité climatique, plutôt que reproduire la courbe de la figure 21 du rapport, nous allons essayer de caler sa valeur en utilisant d'une part les observations de NASA-GISS, d'autre part les forçages (estimés par NASA-GISS).

Ces forçages sont traités par le modèle simple utilisé sur ce site, sans toucher au forçage solaire, et en extrapolant pour 2011 et 2012.

Le modèle, qui comprend une simulation de l'ENSO, donne l'anomalie de température mensuelle qui est ensuite moyennée annuellement puis lissée (polynomial 21 ans).

Les résultats sont illustrés ci-dessous:

Les observations mensuelles NASA également moyennées et lissées (en vert) sont encadrées par les simulations de sensibilités respectives 2.5°C et 3.5°C.

On en conclut que la sensibilité "réelle" est plutôt de l'ordre de 3.0°C +- quelque dizièmes de °C.

On est très loin, de toute façon, d'une sensibilité supérieure à 5°C nécessaire, dans ce modèle, pour obtenir 4°C en 2060.

Application aux RCP

Dans la courbe ci-dessous figurent les anomalies de température pour RCP6 et RCP8.5 avec la sensibilité déterminée ci-dessus.

Attention nous n'avons pas inclus l'ENSO dans les reconstructions ce qui explique une bonne partie du décalage observé en 2012.

Conclusion

La détermination de la sensibilité, suivant cette méthode de calage, tient compte d'estimations de forçages radiatifs.

Ces forçages sont sujets à une forte incertitude du fait de l'incertitude sur les forçages d'aérosols (effets direct et surtout indirect).

Néanmoins, avec les forçages médians estimés par NASA-GISS, nous obtenons une sensibilité de 3°C, très proche de la sensibilité médiane donnée par le GIEC (3.2°C dans l'AR4).

Avec cette sensibilité, l'anomalie maximale est de 4.1°C en 2100 pour le RCP8.5 et de 2.8°C pour le RCP6.

Nous sommes assez loin, fort heureusement, de l'anomalie maximale en 2100 qui serait de l'ordre de 6°C si elle était de 4°C en 2060.

Une anomalie maximale de l'ordre de 3°C en 2100 sous entend une élévation de température de l'ordre de 2°C par rapport à l'actuelle.

Ce n'est peut-être pas un cataclysme mais 3°C est une variation qui correspond, si on veut se fixer les idées, à environ 60% de l'amplitude de température des cycles glaciaires.

Si les variations de l'écosystème induites sont proportionnelles à la variation de température, une variation de 3°C entraîne déjà des effets très significatifs..

Un petit exemple: une variation de 5°C fait varier le niveau des océans de 100m.

3°C, ou plus (la température monte encore au 22ème siècle), pourrait entraîner, sur le long terme, une élévation du niveau des océans de l'ordre de la dizaine de mètres, voire plus.

Sur une planète dont la population humaine est de 1 million d'habitants, ce n'est pas trop gênant, mais si la population humaine est encore de plusieurs milliards, par hypothèse, dans les siècles à venir, çà l'est nettement plus.

*1: le CO2 équivalent comprend les gaz à effet de serre et les aérosols.(caractéristiques des scénarios RCP ici.)

Je pensais encore, il y a quelque temps, que la sensibilité climatique était plutôt dans la partie basse de la fourchette 2-4°C établie par le GIEC dans son dernier rapport.

C'est vraisemblablement l'influence de la stagnation actuelle des températures qui m'influençait dans ce sens.

La nouvelle étude du Berkeley Earth apporte cependant des éléments inquiétants qui iraient dans le sens d'une sensibilité très élevée entraînant un changement climatique aux conséquences catastrophiques.

Cette conclusion, qui m'est propre, est issue d'hypothèses simplificatrices et des calculs habituels effectués ici sur lesquels je ne reviendrai pas mais qui sont précisés un peu partout dans le blog.

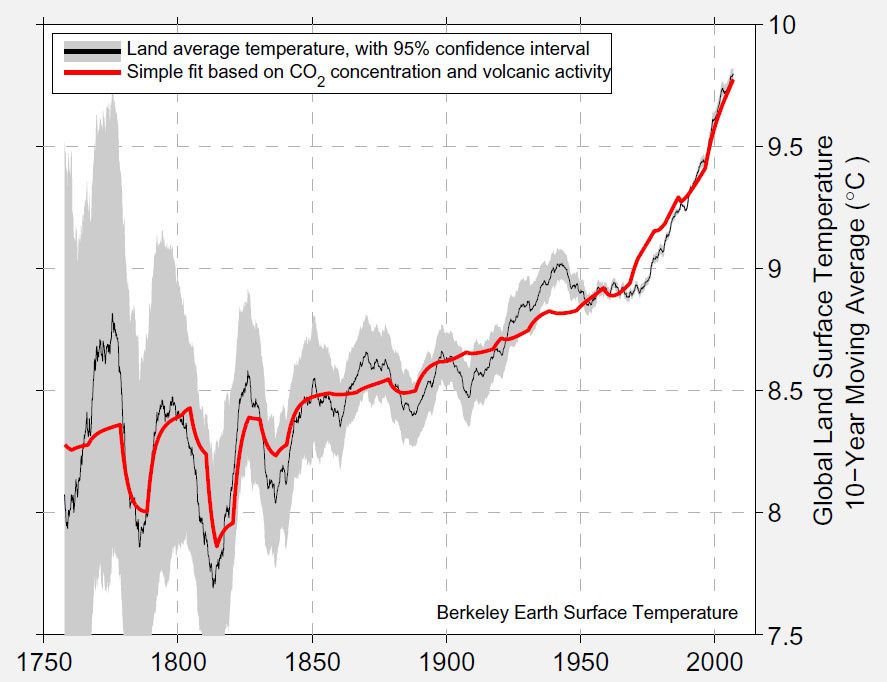

Il s'agit principalement d'une reconstruction de températures des terres depuis 1753 à partir de données instrumentales.

Ces données sont partielles au tout début puis concernent une partie de plus en plus grande des surfaces continentales.

On peut suivre l'évolution de ces surfaces dans cette vidéo.

En parallèle avec cette reconstruction les auteurs établissent un fit simple de l'évolution de la température à partir du CO2 seul et des volcans.

La courbe rouge ci-dessous représente ce fit alors que la courbe noire est la moyenne décennale de la reconstruction et le domaine grisé l'intervalle de 95% de confiance.

Evidemment, les oscillations de la température reconstruite sont fortes en début de courbe.

Ceci peut être dû à une insuffisance de surface de mesure ou à des oscillations réelles.

Mais la correspondance entre le fit et la courbe donnant l'allure générale de l'augmentation de température des terres depuis 1753 est saisissante.

Il s'avèrerait donc que la température des terres a augmenté de 1.5°C depuis cette date.

quelques calculs et projections

J'ai utilisé le modèle modifié décrit ici pour contraindre le coefficient de sensibilité, S, avec cette anomalie de 1.5°C.

Pour l'atteindre, avec un fit qui comprend le CO2 uniquement, il faut un coefficient de sensibilité climatique de 1.6 °C.m2/W, correspondant à une sensibilité climatique à l'équilibre de 5.9 °C.

C'est presque le double de la valeur médiane de sensibilité du GIEC AR4 égale à 3.2°C.

Pour aller un peu plus loin j'ai voulu regarder le futur en supposant des émissions "raisonnables" de CO2, provenant de la combustion du carbone fossile.

Ces émissions futures sont estimées à 1000 Gt de 2012 à 2100, et 2150 Gt de 1750 à 2200.

(exprimées en carbone).

Le cycle du carbone utilisé a déjà été décrit ici.

Le scénario d'émissions (avec des Land-Use calibrées) est représenté ci-dessous:

La température des terres simulée, en rouge, ainsi que la reconstruction Berkeley, en noir, sont représentées sur ce graphique:

On atteint 4.5°C d'augmentation en 2100 sur les terres soit 3°C de plus qu'en 2010.

En 2200 on est à 6.4°C, en augmentation.

Ceci en moyenne, avec de fortes disparités régionales (non calculées ici bien sûr mais dont on peut avoir un aperçu dans cet article).

Les SST, qui mènent le bal, sont également très élevées: 3°C en 2100 et 4.2°C en 2200.

Je n'insisterai pas trop sur les conséquences de telles poussées de fièvre, mais on peut supposer qu'il y aurait forte réduction de la surface des terres habitables, disparition totale des glaciers continentaux, début d'une débâcle cataclysmique des inlandsis du Groenland et de l'Antarctique promis à une disparition sans doute complète dans les siècles suivants.

Les effets sur le cycle du carbone seraient à prendre en compte avec la disparition du permafrost, libérant des quantités considérables de CO2 et de méthane, amplifiant encore le réchauffement.

Le cycle océanique du carbone serait également profondément perturbé.

Mais le pire n'est pas sûr, les hypothèses simplificatrices utilisées ici, par exemple la constance parfaite de la sensibilité climatique, n'ont pas de justification bien établie quoique je n'ai pas vu d'études indiquant de fortes variations de cette sensiblité dans des intervalles, par exemple, de 10°C.

La Terre a déjà connu, semble t-il, des conditions similaires à celles qui règneraient si la simulation était exacte.

L'extrême rapidité, cependant, des modifications climatiques envisagées, engendrerait vraisemblablement des phénomènes de "grande extinction" des espèces, comme notre planète en a connues quelques-unes, quoique d'aucuns diront qu'il n'y a plus grand-chose à "éteindre".

Elle serait de toute façon, à mon sens, incompatible avec une société humaine aussi nombreuse qu'actuellement et ainsi structurée.

Il n'est pas déraisonnable de se demander si la stagnation de la température globale, que nous connaissons depuis plus de 10 ans, peut encore continuer quelques années.

On entend souvent, chez certains, cet argument qui évoque la très faible augmentation de température globale au regard de quantités toujours plus massives de CO2 injectées dans l'atmosphère.

Evidemment c'est complètement faux comme on l'a vu plusieurs fois ici et ailleurs.

Mais il est bon de savoir que l'argument en question, bien que faux, risque d'être encore utilisé pour cette année 2012 et peut-être pour les toutes prochaines.

3 facteurs principaux influencent, de façon récurrente, l'anomalie globale de température.

- l'influence anthropique par injection de gaz à effet de serre, d'aérosols, de modification d'usage des sols

- l'anomalie de forçage solaire (cycle de 11 ans)

- l'ENSO qui assure au moins 70 % de l'écart-type de variabilité interannuelle.

D'autres facteurs plus aléatoires, comme le volcanisme, peuvent avoir une influence de refroidissement non négligeable, mais leur caractère totalement imprévisible interdit de les faire intervenir dans une quelconque prédiction.

Quant aux oscillations de portée globale et de plus longue durée (PDO, AMO) elles sont de faible intensité et ne nous intéressent pas, de toute façon, dans la variabilité annuelle (hormis pour la relation PDO/ENSO)

J'ai donc tenté une simulation à l'aide du modèle simple utilisé habituellement ici, en prenant en compte un effet anthropique équivalent à celui d'un doublement de la teneur en CO2 en 100 ans, des données TSI (irradiance solaire) issues de PMOD, des valeurs de l'indice ENSO (anomalie Niño 34).

Pour la TSI j'ai considéré une activité moyenne constante jusqu'en 2014, année plus ou moins prévue du maximum du cycle 24 que j'ai donc supposé être un maximum très plat (pas très éloigné de la moyenne de l'activité solaire), et pour l'ENSO, j'ai pris en compte les prévisions qui annoncent un prochain El Niño plutôt faible à moyen.

A la suite de cet épisode j'ai supposé que nous aurions une répétition de la Niña bifide qui s'était déroulée de la fin 2010 au début 2012.

Cette hypothèse est vraisemblable étant donné que nous sommes en PDO négative, peu favorable aux forts Niño, mais très favorable aux Niña longues et fortes.

Le graphique ci-dessous résume le travail réalisé:

Il permet de voir que:

- la simulation (ici des températures de surface de l'océan) est assez bien corrélée aux températures mesurées par la NOAA, ce qui, d'une certaine façon, valide le modèle (mis à part les épisodes volcaniques non pris en compte).

- la température globale continue à stagner voire baisser en 2012, 2013, 2014.

- le réchauffement anthropique sous-jacent se confond avec la tendance des SST mesurées.

- sur le long terme, pris ici arbitrairement à partir de 2015, en considérant l'activité solaire et l'ENSO neutres, l'évolution finit par se confondre avec le réchauffement anthropique seul.

Pour l'anecdote, les anomalies des prochaines années, dans ces hypothèses, seraient:

- pour 2012 : 0.39°C (égale à 2011 mesurée).

- pour 2013: 0.38°C

- pour 2014: 0.34°C

par rapport à la moyenne des températures de surface de l'océan de 1901 à 2000.

C'est donc une stagnation qui continue, et une légère baisse est même possible, malgré un contexte long terme de réchauffement, évident dans la simulation.

conclusion

Ceci veut dire que nous n'avons donc peut-être pas fini d'entendre l'argument, toujours aussi fallacieux, des "quantités toujours plus massives de CO2 injectées dans l'atmosphère, sans contrepartie côté température".

Faudra continuer à s'y faire...

PS: l'anomalie de SST pour 2012 a été finalement de 0.45°C soit légèrement supérieure au 0.39°C prévu.

J'ai trouvé amusant cette petite animation (parue sur Skeptical science) qui traduit bien la difficulté à établir une tendance long terme sur de trop petites périodes.

Ceci dit ce genre d'animation, qui a "un peu" pour vocation de ridiculiser la "science" sceptique, peut être dangereux tout de même pour les "réalistes" car on voit bien que l'écart entre les deux dernières marches est bien plus petit que celui des marches précédentes, même s'il s'agit de droites de tendance pas très évidentes à raccorder.

Les périodes ne sont d'ailleurs pas égales, ce qui veut, peut-être, traduire l'incohérence de cette même science sceptique, mais ce n'est pas très évident, me semble t-il, et peut prêter à confusion .

Quant à parler d'escalier, ou d'escalator sur Skeptikal Science, il vaut mieux, à mon avis, que les marches soient horizontales et qu'elles soient de la même longueur, à défaut d'être de la même hauteur.

horizontales et de même longueur c'est indispensable si on ne veut pas rater une marche et se casser la figure.

la hauteur, sauf s'il y a une marche très très haute,...

enfin, vous voyez ce que je veux dire.

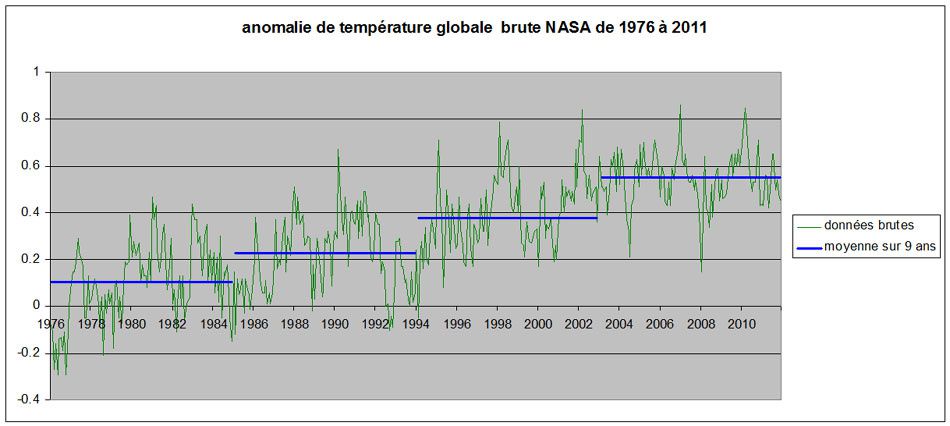

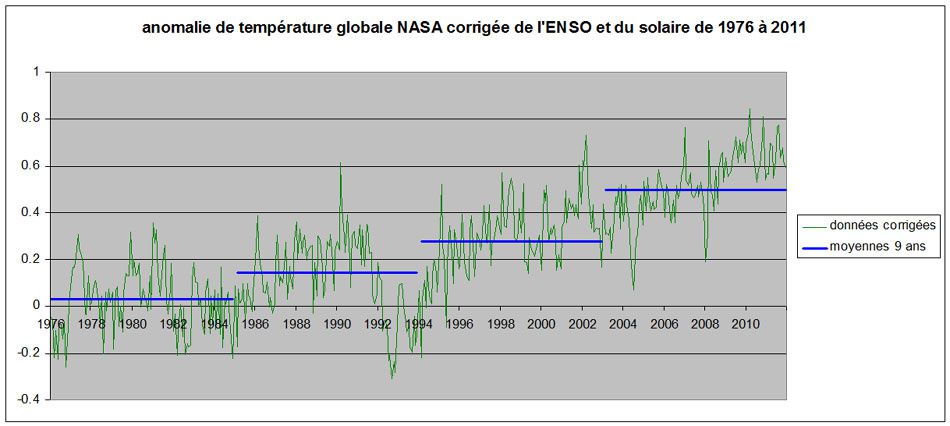

Pour respecter l'horizontalité et la longueur j'ai donc adopté les moyennes sur 9 ans sur la période 1976-2011 choisie dans la cadre de l'article précédent

Voici d'abord les données NASA brutes avec les moyennes:

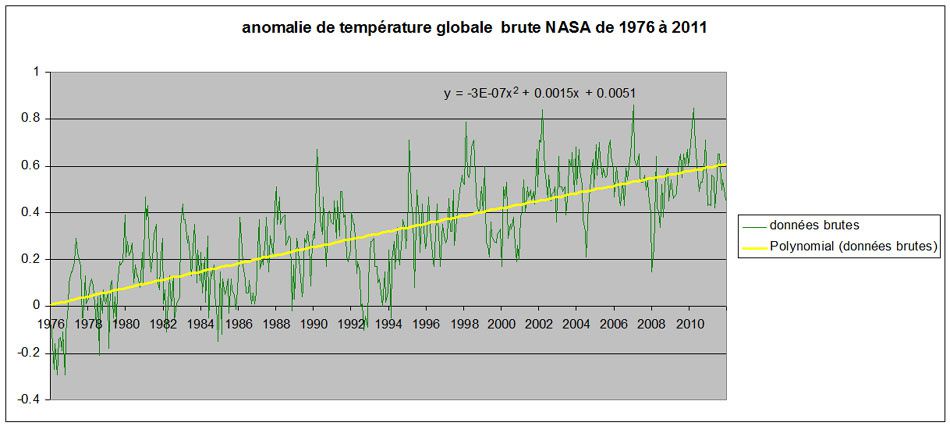

puis avec la tendance linéaire:

et enfin la tendance polynomiale du second ordre:

Maintenant les données corrigées de l'ENSO et du solaire avec les moyennes:

puis avec la tendance linéaire:

et enfin avec la tendance polynomiale du second ordre:

J'en profite pour ajouter qu'il s'agit des données mensuelles.

Bon, c'est sûr que c'est moins marrant que l'animation de skeptical science, mais on peut, malgré tout en tirer quelques enseignements peut-être plus intéressants, à défaut d'être plus satiriques.

écart entre les marches:

il semble croître régulièrement, surtout dans le cas "corrigé, mais pas dans la dernière vingtaine du cas "brutes".

tendance linéaire:

Elle passe de 0.167°C/décennie pour les données brutes, ce qui est plutôt pas mal, à 0.180°C/décennie pour les données corrigées, ce qui représente une augmentation de 8% par rapport aux données brutes et laisse entrevoir, toutes choses étant égales par ailleurs, une augmentation de température virtuelle (c'est à dire débarrassée de ses composantes variables courtes), de 1.6°C, par rapport à maintenant, en 2100.

Cette dernière valeur est compatible avec des sensibilités climatiques de l'ordre de 3°C, voire supérieures.

tendance polynomiale du second ordre:

C'est à prendre avec précaution, bien sûr, comme le reste, mais alors que cette tendance polynomiale est presque linéaire pour les données brutes, elle semble être de pente croissante pour les données corrigées ce qui serait plus problématique pour la température à la fin de ce siècle, si la tendance se poursuivait.

On aboutirait ainsi à +4.2°C par rapport à 2010.

Ce chiffre, très important, est à prendre avec une grande prudence, d'une part parce que mes corrections n'ont pas fait l'objet de vérifications de la part d'experts (elles ont cependant leur logique), d'autre part parce qu'il n'est pas évident que ce qui drive la tendance réelle de fond est amené à perdurer.

Mais, même s'il ne faut pas se focaliser sur les chiffres, il me semble important de rappeler que l'interprétation actuelle des données brutes, faite avec une malhonnêteté manifeste par pas mal de sceptiques, est loin de permettre la déduction qu'un nouveau Petit Age Glaciaire va se produire au 21ème siècle.

Au contraire, la tendance de fond est toujours là, loin de faiblir.

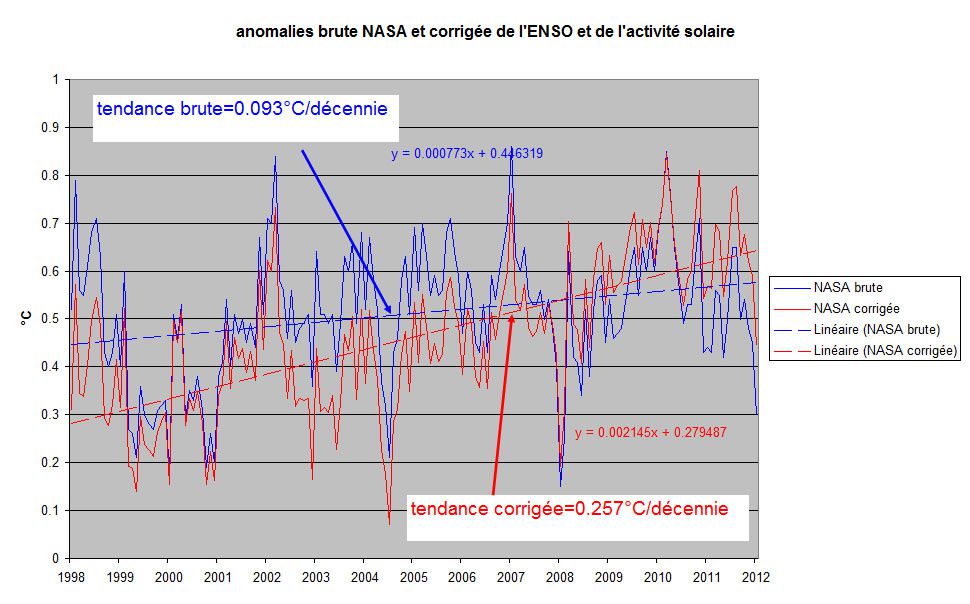

Les lecteurs habituels de ce blog connaissent depuis longtemps mon affreuse manie de corriger la température globale des facteurs naturels que sont l'ENSO et la TSI.

Je rappelle que l'ENSO, qui est une oscillation climatique touchant le Pacifique équatorial est responsable de 70% de la variabilité climatique interannuelle et que la TSI est liée à l'activité solaire.

Cependant, je n'avais pas encore réalisé une correction mensuelle de cette température et je dois dire que le résultat est assez surprenant.

En effet, le fait de travailler, comme je le faisais auparavant en moyenne annuelle, avait tendance à lisser un peu trop les résultats, surtout concernant l'ENSO, dont la variabilité est inférieure à l'année.

Je vais donc présenter ici, l'anomalie de température mensuelle, depuis janvier 1998, mesurée par la NASA, brute et corrigée de ces deux influences.

Pourquoi 1998?

Parce que c'est l'année "cherry-pickée" des sceptiques, non pas parce que l'El Niño de 1998 est un évènement climatique particulièrement intéressant, non, pensez-vous, cela ne les a pas effleuré.

C'est bien sûr parce que cet El Niño là étant particulièrement puissant, son influence sur la température globale a été très forte.

Mais qui, sinon un sceptique, aurait osé choisir cette année là comme borne inférieure de la période récente et d'en tirer la conclusion que le réchauffement s'est interrompu?

Personne d'honnête sans doute.

Les sceptiques l'ont fait et refait jusqu'à plus soif et le font toujours.

Alors, sûr que si vous choisissez une année exceptionnellement chaude au début d'une période, et que la fin de celle-ci est marquée par quelques années plutôt fraîches , évidemment, vous pouvez en déduire que la tendance n'est pas, ou plus, à la hausse.

Et jusque là vous avez raison.

Mais aller dégoiser ensuite sur le fait que les modèles sont faux et que ceux qui les utilisent sont, au mieux, de mauvais scientifiques, au pire que ce sont des tricheurs de la pire espèce qu'il faut pourchasser (surtout quand on est républicain aux US!) et punir sévèrement, là, je suis sûr que vous n'oseriez pas.

Mais c'est vrai que vous êtes honnêtes.

Ceci dit, insidieusement, l'opinion commence à croire que, finalement, nous n'avons rien à craindre d'un réchauffement qui ne serait que l'expression de variations naturelles et que la température va tranquillement rebaisser, si nous ne nous précipitons pas vers un nouveau "Petit Age Glaciaire" (voir Dailymail).

Alors, bon, je ne suis pas le chevalier blanc et les scientifiques sont aptes, je suppose, à se défendre sans mon aide.

Toutefois, comme j'anime un blog qui concerne l'évolution climatique je me sens obligé de réagir lorsque la pression sceptique remonte quelque peu.

Je sais pas pourquoi, c'est comme çà…

Bref, j'ai déjà exposé ici les calculs qui aboutissaient à la correction de la température globale de surface et je n'y reviens pas, sauf pour dire que maintenant je simule l'ENSO comme une perturbation océanique entre surface et couches profondes océaniques (çà marche pas trop mal) et que j'applique 1.18 de facteur multiplicatif à l'anomalie de SST obtenue par mon petit programme pour calculer l'anomalie globale.

Voici les résultats, donc.

On passe d'une tendance brute (en bleu) de 0.093°C/décennie, à peine significative peut-être si on tient compte de la variabilité mensuelle, à une tendance corrigée (en rouge) de 0.257°C/décennie.

Evidemment, n'ayant pas la mentalité sceptique, je n'aurai pas l'outrecuidance de considérer la tendance corrigée comme la valeur vraie du réchauffement de fond.

1998-2011 çà fait 14 ans, et c'est trop court pour établir une tendance de fond.

Mais il devient sans doute plus difficile de prétendre que le réchauffement s'est arrêté à partir de 1998, non?

Sauf que, dans le domaine de la mauvaise foi, l'imagination devient, plus que jamais, la folle du logis…

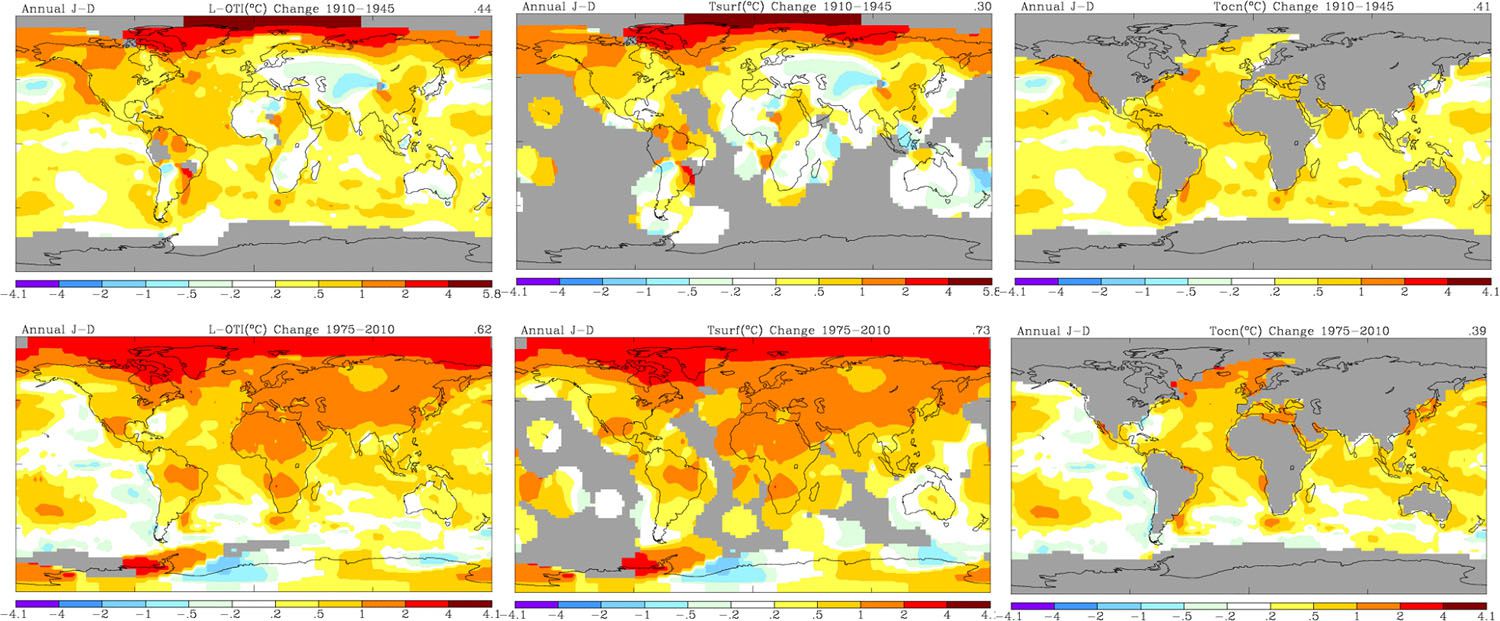

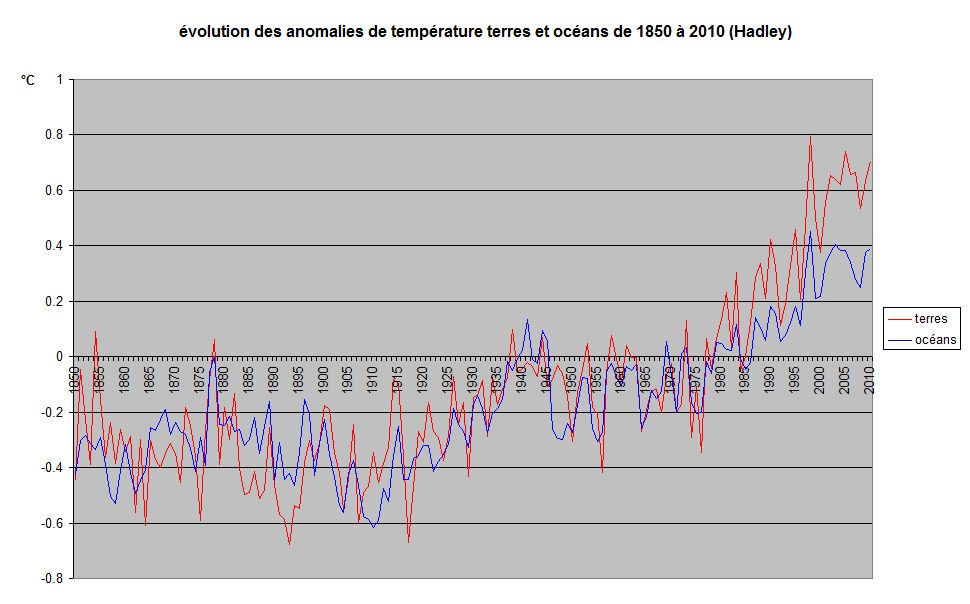

Les bases de données de température, notamment celle du Hadley Center, montrent deux augmentations successives principales de température, 1910-1945 et 1975-2010, au cours de ces 160 dernières années.

La température de surface varie de deux manières différentes :

- par la variabilité interne du système terrestre

- par les forçages

La variabilité interne qui se produit sur des échelles de temps très courtes, détermine, en plus des variations imposées par les saisons, tout simplement le temps qu’il fait.

Par exemple, on a vu sous nos latitudes tempérées, des Noël au balcon à 15°C et des Noël blancs et froids à -15°C (certes de plus en plus rares malheureusement).

Cette variabilité est donc suffisamment puissante, localement, pour effacer complètement l’influence saisonnière sur des intervalles de temps de la journée à la semaine.

Sur une saison complète, toujours localement, les différences de température moyenne par rapport à la climatologie sont évidemment plus faibles, de quelques degrés seulement.

A l’échelle du globe, les variations locales jouent souvent en sens inverse et le résultat moyen est que lavariation moyenne globale est bien plus faible.

La variation interannuelle est typiquement de 0.1°C et peut aller, assez rarement, à 0.4°C, au maximum.

Lorsque l’on considère des périodes plus grandes, la variabilité est bien plus difficile à mettre en évidence.

Elle rentre en concurrence, du moins sur le plan théorique avec l’influence des forçages qu’ils soient naturels, solaire et volcans notamment, et anthropiques, gaz à effet de serre, aérosols, changements d’usages des sols, …

Les variations internes répertoriées , celles qui s’appliquent au long terme, sont liées exclusivement aux océans.

Il s’agit de l’AMO (Atlantic Meridional Oscillation) et de la PDO (Pacific Decadal Oscillation).

Nous avons déjà souvent parlé ici de ces oscillations et on notera que le terme oscillation qui fait penser à quelque chose de périodique genre sinusoïde est quelque peu galvaudé puisqu’on se pose encore des questions sur leur caractère réellement cyclique.

L’AMO correspond à un signal global d’amplitude 0.1°C et la PDO à un signal global deux fois inférieur, 0.05°C donc.

Leur combinaison arithmétique, qui n’est pas forcément justifiée, peut donner des écarts maxi de 0.3°C sur des intervalles de temps de plusieurs décennies.

Le problème principal qui se pose, dans le contexte actuel, est de différencier les variations de température provenant de la variabilité interne et celles provenant du forçage donc par définition, de quelque chose d’extérieur au système.

Il existe des moyens pour réaliser cette attribution qui font intervenir des modèles climatiques.

En gros on réalise une analyse spatio-temporelle du réchauffement pour en connaître l’origine.

Je n’ai guère de doute sur la performance de ces modèles pour attribuer le réchauffement récent aux GES anthropiques.

Cependant la simple logique peut permettre d’avoir une amorce, qui nécessiterait un approfondissement évidemment, pour être plus définitive.

Cette logique est la suivante :

La température des terres dépend, grandement, de la température des océans, mais en cas de forçage global, l’inertie thermique des terres très inférieure à celle des océans, permet une variation de température bien plus forte sur les terres que sur les océans.

On peut faire une analyse spatio-temporelle très simple, et plutôt large, en observant les variations de température comparées des terres et des océans de ces deux périodes d’élévation de température que sont 1910-1945 et 1975-2010.

L’examen des températures, globale, océanique, terrestre, relevées par la NASA et figurant sur les graphiques ci-dessous, apporte des éléments, intéressants.

1910-1945 est au dessus et 1975-2010 en dessous

de gauche à droite: global/terres/océans

Pour les deux périodes les valeurs des variations de température des océans (SST) sont très proches.

Elles présentent cependant des différences notables de répartition spatiale et on distingue bien les influences de l’AMO et de la PDO ainsi qu’un refroidissement de l'océan austral au cours de la période récente.

Mais surtout on constate une très forte différence entre les variations des températures des terres pour les deux périodes.

Si on examine les données de la base Hadley, dans la dernière période, l'écart entre terres et océans s'accroît bien d'avantage que dans n'importe quelle autre période des 160 années de la base.

Le différentiel terres/océans (moyenne glissante sur 10 ans) est assez parlant.

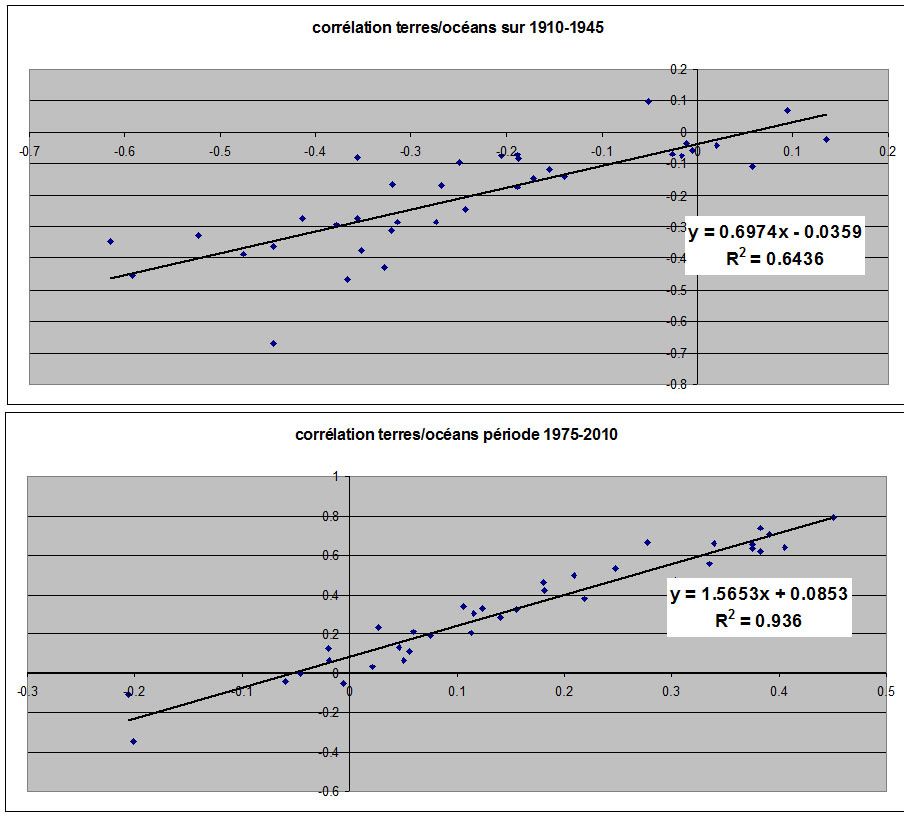

Les corrélations terres/océans sur les deux périodes sont également révélatrices.

La corrélation est plutôt moyenne dans la période 1910-1945 (R2=0.64) et la droite de tendance a une pente de 0.7 qui représente le rapport entre les terres et les océans.

Dans la période 1975-2010 la corrélation est excellente entre les deux milieux (R2=0.94) mais surtout la droite de tendance a cette fois une pente de presque 1.6 entre les températures des terres et des océans.

Interprétation possible

De 1850 à 1975 environ (un peu au-delà en fait) le différentiel de température entre terres et océans oscille de plus ou moins 0.1°C (écart-type sur la moyenne 10 ans = 0.074°C), mais à partir de 1975 le différentiel s'accroît fortement jusqu'à atteindre des valeurs jamais vues au cours de ces 160 dernières années.

D'un point de vue strictement thermique étant donnée sa capacité thermique énorme c'est l'océan qui influence les terres plutôt que l'inverse.

En l'absence de forçage les deux doivent évoluer de concert mais avec des différences dues aux changements de circulation atmosphérique, centres d'actions, etc.

Si on voit les deux évolutions complètement calquées l'une sur l'autre on peut se dire que l'océan influence parfaitement les terres mais si les terres, en plus, se réchauffent nettement plus que les océans, il semble probable qu'un forçage soit à l'origine des variations puisque les terres ont une capacité nettement moindre que celle des océans et se réchauffent donc plus vite.

C'est bien le cas pour la période 1975-2010.

J'arrêterai là ce début d'attribution.

Des modèles climatiques type AOGCM doivent pouvoir réaliser plus finement cette attribution et mettre en évidence l'influence d'un forçage global.

Ils l'ont fait et c'est pourquoi il n'existe que très peu de chances que la variation récente soit une résultante de la variabilité interne du climat.

Les candidats pouvant contribuer au forçage global ne sont pas légion.

Parmi les principaux on citera les GES, les aérosols troposphériques, et la vapeur d'eau stratosphérique...