Cette limite de 2°C d'augmentation de température par rapport à l'ère préindustrielle, est communément citée comme la limite à ne pas franchir pour éviter certains phénomènes

irréversibles.

L'objet de cet article n'est pas de discuter la validité de ces 2°C, mais d'examiner, avec des méthodes propres à ce site, la possibilité ou non, suivant certaines hypothèses, d'atteindre

cette limite en utilisant toutes les réserves connues de carbone fossile.

1- hypothèses de base

Nous considérons uniquement l'effet du CO2.

Cette hypothèse s'appuie sur le fait que l'effet négatif des aérosols compense partiellement l'effet positif des autres GES (CH4, N2O, O3,..)

Dans les modèles du GIEC le forçage total est supérieur de 15-20% environ à celui du CO2 pur.

Cependant, étant donné l'état des incertitudes, tant en ce qui concerne les aérosols que les émissions des autres GES, la seule chose relativement robuste reste l'effet du CO2.

C'est de plus l'effet qui subsiste sur le long terme, si l'on excepte certaines molécules exotiques (fluorocarbures par exemple).

2- méthodologie

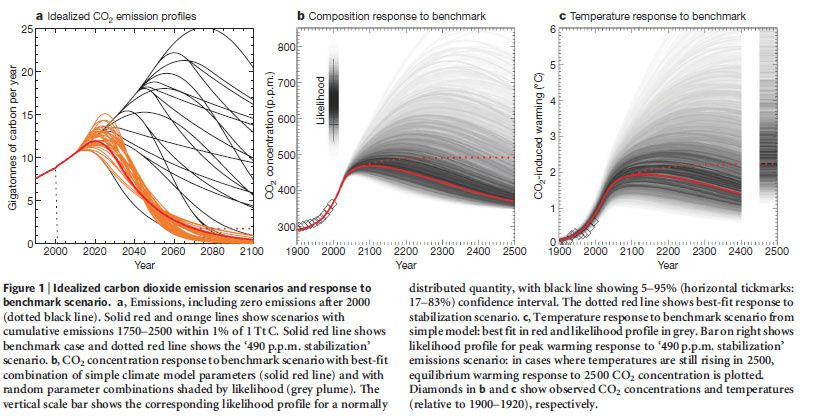

Le modèle de cycle de carbone utilisé est un modèle simplifié issu de Bern 2.5CC.

l'équation de base est la suivante:

m/m0 = a0+a1exp(-t/T1)+a2 exp(-t/T2) +a3exp(-t/T3)

où

a0 = 0.217, a1 = 0.259, a2 = 0.338, a3 = 0.186, T1 = 172.9 years, T2 = 18.51 years, and T3 = 1.186 years.

Il s'agit de l'évolution temporelle de la masse atmosphérique de CO2, en fonction d'une impulsion m0.

état des réserves

les réserves concernent les quantités connues et prouvées de carburant fossile qui sont encore dans le sous-sol.

Ceci exclut ce que l'on appelle les ressources qui concernent les quantités que l'on pense pouvoir trouver dans le futur, étant donné certaines informations plus ou moins objectives.

L'état des réserves est bien entendu soumis à controverse car les mesures pour les quantifier ne sont pas très simples et les informations émanent d'Etats ou de gouvernements dont les intérêts ne

sont pas toujours en faveur de la plus grande vérité.

Nous considérons ici l'état des réserves tel qu'il figure dans le

rapport BP2009.

Exprimé en Gt de carbone, il se décline de la façon suivante:

gaz

naturel:

127

pétrole (et sables bitumineux du Canada) :

164

charbon :

826

soit un total de

:

1117 GtC

Dans le cas qui sera étudié ici, en tant qu'hypothèse réaliste, nous considérerons donc, une quantité totale de 1500 Gt, en sachant que 463 Gt ont déjà été consommés (émis)

depuis 1850 environ.

Ces 463 Gt concernent le carbone émis par combustion des fossiles et celui émis du fait de l'usage des sols.

Par rapport aux 1500Gt du scénario, il reste donc 1037Gt à émettre.

Ces 1037 Gt comprennent le CO2 qui sera émis du fait de l'usage des sols, soit une quantité assez variable, mais cela permet de laisser intact un talon de carburant fossile de l'ordre

de 200Gt.

évolution des émissions

On choisit des profils d'émissions en forme de cloche (courbes de Gauss exactement).

Ces profils correspondent à ce qui est modélisé et observé sur différents gisements de par le monde.

modèle climatique

Le modèle utilisé est le modèle océanique multicouches établi ici.

Les données en entrée sont l'évolution du forçage radiatif et la sensibilité climatique.

Le modèle calcule la réponse de la température de la couche de surface.

validité du modèle utilisé par rapport aux modèles du GIEC (TAR)

les données du scénario AB1 du GIEC sont entrées dans le modèle CE.

rappelons que la sensibilité climatique, lors du TAR, était de 3.5°C, mais que par la suite (après la validation) nous utiliserons 2.78°C.(soit 0.75°C.m2/W)

Ci-dessous la comparaison entre les sorties température indiquées par le GIEC et celles de CE en partant de la même température initiale en 1990.

Les valeurs sont très proches et l'on peut donc accorder une bonne confiance au modèle utilisé du moins par rapport aux modèles du GIEC.

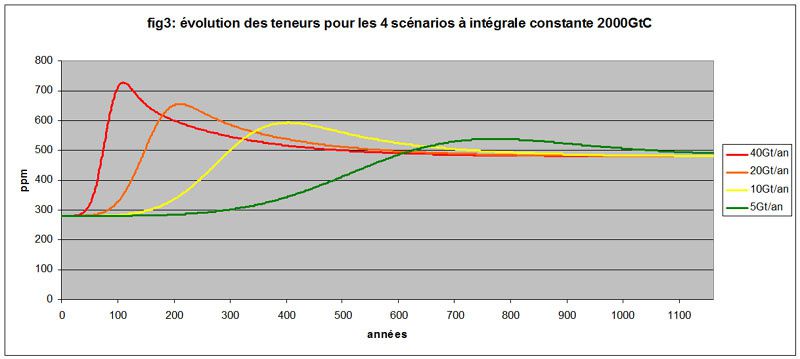

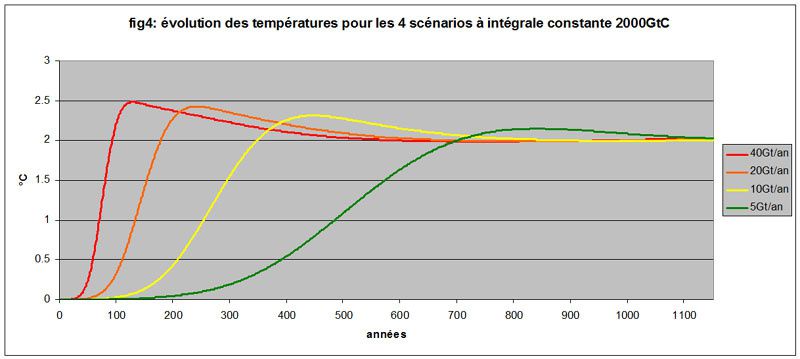

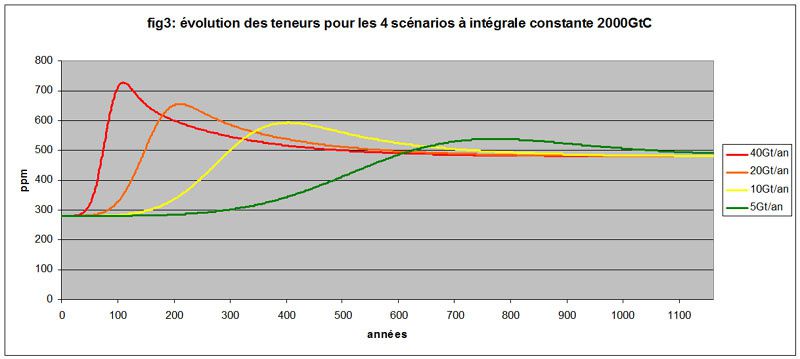

Influence de l'intensité des émissions pour une intégrale donnée

Avant d'étudier notre cas réaliste, il est intéressant de regarder l'influence de la valeur maximale d'émissions annuelles pour une même quantité totale (intégrale) émise

dans l'atmosphère.

Nous étudions donc ici 4 courbes de Gauss correspondant à la même quantité totale émise, 2000 Gt, avec respectivement des émissions maximales de 40, 20, 10, 5 Gt/an.

Ceci correspond à des scénarios qui vont d'une consommation frénétique à une consommation très tranquille de père de famille soucieux du lendemain.

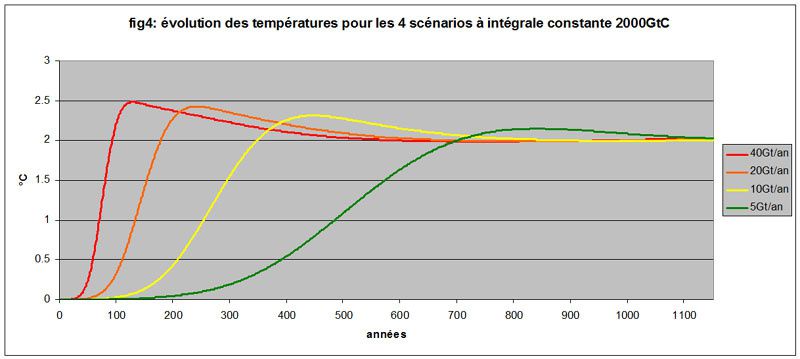

Ci-dessous les 4 scénarios d'émission, suivis des 4 évolutions de teneur en CO2 dans l'atmosphère et des 4 évolutions de température.

D'emblée, il apparaît que nous n'échappons pas, dans ce cas de figure, à la même température finale de 2°C environ.

Les températures maximales atteintes sont finalement très proches mais ce qui change c'est la rapidité d'obtention de ces températures.

On peut donc en conclure qu'une gestion très économe par rapport à une autre (8 fois plus économe en quelque sorte) ne change pas la température finale, à masse totale injectée identique.

Le bénéfice en terme de température maximale est faible si on le compare à l'effort énorme qu'il faut entreprendre pour réduire d'un facteur 8 la consommation de fossile et, dans

tous les cas, le seuil de 2°C est dépassé.

Par contre, une gestion économe (dans le sens d'une consommation annuelle réduite) permet une pente d'augmentation beaucoup plus faible qui permet elle-même, du fait du recul du pic de

température, l'adaptation et la mitigation , c'est-à-dire la mise en oeuvre de mesures alternatives, pour diminuer les émissions.

On ne peut donc pas dire que l'intérêt d'une gestion économe soit nul en termes climatiques, mais il est clair aussi que si l'on n'agit pas sur l'intégrale, on est moins efficace.

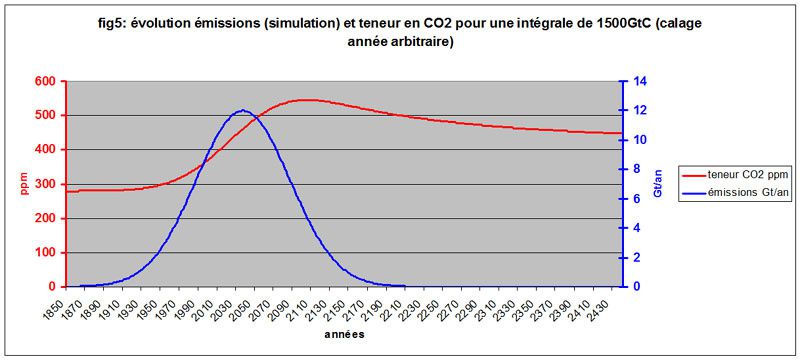

3- cas réaliste

c'est le cas qui, comme nous l'avons vu, correspond à 1500 GtC émis depuis l'époque préindustrielle (voir plus haut)

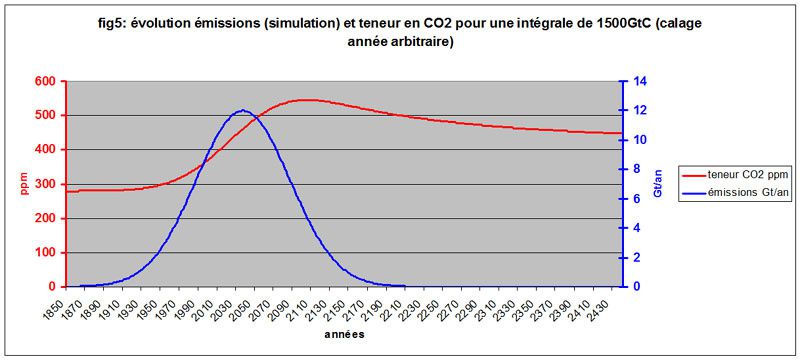

Nous représentons ci-dessous 2 graphiques.

le premier concerne la courbe des émissions et celle de la teneur en CO2 atmosphérique, le second l'évolution de la température et les émissions cumulées.

(attention aux échelles de temps différentes)

Bien entendu, le calage annuel est arbitraire, mais pour une quantité émise de 463Gt qui correspond à la quantité déjà injectée, on retrouve un écart de température de 0.8°C environ, soit très

proche de ce que nous constatons actuellement.

Ceci constitue une validation supplémentaire (en plus de celle du scénario A1B du GIEC) du process employé ici.

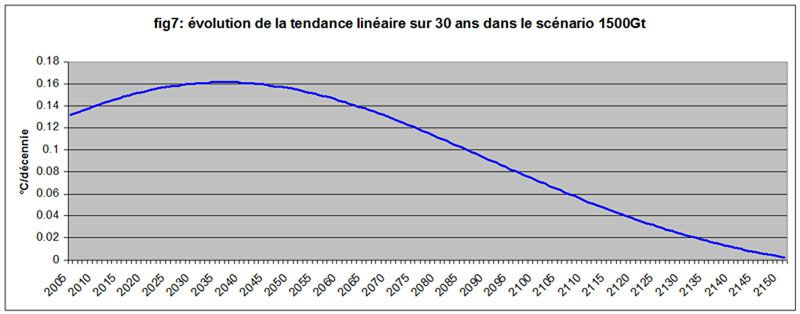

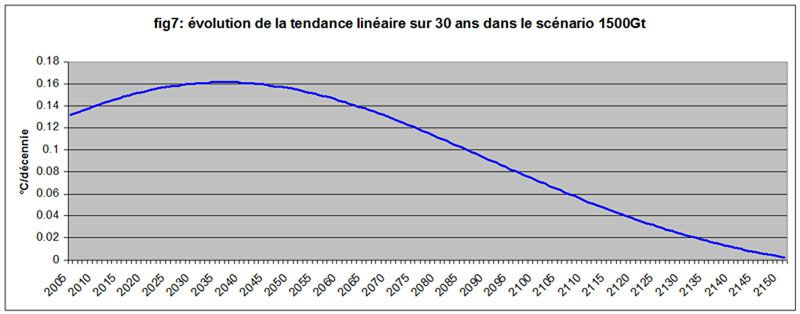

EDIT1:Il est intéressant de voir ce que donne la tendance linéaire sur 30 ans dans ce scénario réaliste fort proche, du moins jusqu'en 2010, du scénario du monde réel.

La tendance de 1976 à 2005 est de l'ordre de 0.13°C/décennie, pour une tendance mesurée de 0.16°C/décennie.

Nous ne nous sommes pas lancés dans des calculs d'erreur assez fastidieux, mais les ordres de grandeur semblent correspondre, surtout compte-tenu des hypothèses de base.

La tendance décennale du scénario 1500 Gt culmine, vers 2040, à 0.16°C/décennie, pour diminuer ensuite inexorablement.

Mais l'information très importante est que:

Si nous consommons, à partir de maintenant, 80 à 90 % de toutes les réserves connues de carburant fossile, soit 900 à 1000 GtC, nous ne dépassons pas la limite des 2°C préconisée comme limite

supérieure à ne pas dépasser.

4- conclusion

Cette importante information, donnée avec les réserves d'usage et demandant confirmation, nous semble assez robuste, bien que nous n'ayons considéré que le CO2.

Le CO2 est un élément fondamental du forçage radiatif et ce qui peut justifier la non prise en compte des autres GES et des aérosols est que leurs influences se compensent partiellement.

De plus, dans pas mal de cas, les émissions des autres GES (N2O, O3,..) et des aérosols, sont liées à la combustion du carbone.

La grande inconnue reste le méthane, dont l'évolution dépend, en partie, de l'action de la température sur les sols, de l'humidité, etc.

En fonction des hypothèses retenues, la courbe des émissions montre que nous pouvons encore augmenter les émissions jusqu'en 2040 environ, pour atteindre un maximum de 12Gt/an, puis que

nous devons réduire progressivement ces mêmes émissions pour atteindre, tout de même, 5.5Gt/an, soit la moitié des émissions actuelles en 2100.

En 2160 environ, la société humaine doit fonctionner sans, quasiment, aucune émission de carbone.

La quantité totale qui nous reste à émettre, dans ces conditions et suivant ces hypothèses, est donc de l'ordre de 1000 GtC et, si nous suivons le programme d'émissions indiqué, nous ne

risquons probablement pas de dépasser 2°C.

EDIT2:

Pour modérer un peu l'optimisme relatif de la conclusion, on peut noter que l'augmentation de température à très long terme, dans le scénario 1500 Gt, est de 1.5°C.

Cette augmentation est prévue durer des dizaines de milliers d'années, en fonction du cycle géologique.

Si on suit des auteurs comme Hansen (voir ici) elle serait suffisante pour entraîner des modifications profondes de la

cryosphère, engendrant à terme la disparition quasi-totale des inlandsis.(Groenland et Antarctique)

Elle permettrait donc de dépasser la sensibilité rapide (dite de Charney), soit 3°C, pour atteindre une sensibilité long terme de 6°C, et surtout d'atteindre, in fine, au bout de plusieurs

centaines voire milliers d'années, des élévations du niveau de la mer de plusieurs dizaines de mètres (environ 70m au maximum)

Evidemment ce n'est qu'une hypothèse qu'on pourrait penser soulevée ou inventée par Hansen pour les besoins de la cause, mais ce serait faire injure, à mon sens, aux autres scientifiques qui ont

participé à son élaboration.

C'est donc à garder dans un petit coin de sa tête...